сторонний ресурс что это

Исходящие ссылки с сайта – хорошо или плохо для SEO

Сейчас у веб-мастеров и оптимизаторов неоднозначное отношение к исходящим ссылкам: одни говорят, что они полезны для продвижения, другие же настаивают на том, что ссылочный вес должен оставаться внутри сайта, а не распыляться на другие ресурсы. Какая же стратегия правильная, нужны ли сайту исходящие ссылки, какими они должны быть – рассмотрим далее. Также приведём интересное исследование от западных SEO-специалистов.

Что такое исходящие ссылки

Например, в коде сайта https://site1.ru/ исходящая ссылка будет выглядеть следующим образом:

Как и входящие, исходящие ссылки могут быть Dofollow или Nofollow.

В качестве исходящих ссылок чаще всего встречаются:

Дополнительно веб-мастер может разместить платную исходящую ссылку из любого места на сайте.

Исходящие ссылки не являются подтверждённым фактором, влияющим на ранжирование, однако выступают одним из способов понять, о чём сайт или конкретная страница. По факту они являются отражением и/или дополнением информации на странице-доноре.

Как поисковые системы относятся к исходящим ссылкам

Яндекс

Яндекс считает ссылки важнейшей составляющей сети и рекомендует уделять внимание линкам, которыми сайт связан с другими ресурсами. При этом в Яндекс.Помощи не уточнён тип ссылок (входящие или исходящие).

Однако основной акцент сделан на том, что ссылки должны быть естественными (полученными естественным путём) и качественными.

Под качественными понимаем ссылки, которые:

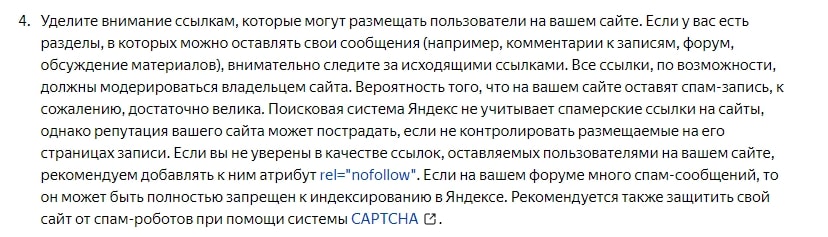

В особенности рекомендуется следить за качеством исходящих ссылок, которые могут оставить пользователи на сайте. Ссылки, которые размещаются на сайте, должны быть контролируемыми, за спамерские линки может пострадать репутация сайта.

В своей справке Google говорит об указании источников информации (в особенности для новостных сайтов). Настаивает на указании анкора и выделении ссылки по сравнению с другим текстом страницы.

Также поисковая система говорит, что исходящие ссылки могут повышать авторитет ресурса. И, как и Яндекс, рекомендует контролировать линки, которые идут из сайта:

Какими должны быть исходящие ссылки

Мы считаем, что исходящим ссылкам на авторитетные ресурсы – быть. Они, как и входящие, повышают качество сайта в глазах поисковых систем. Также исходящие ссылки помогают алгоритмам понять нишу вашего сайта. Дополнительно линки на релевантные и авторитетные домены положительно влияют на ваш рейтинг.

Однако, важно учитывать следующие моменты:

Проверить, считают ли поисковые системы сайт или страницу релевантной запросу, можно с помощью простого поиска по запросу.

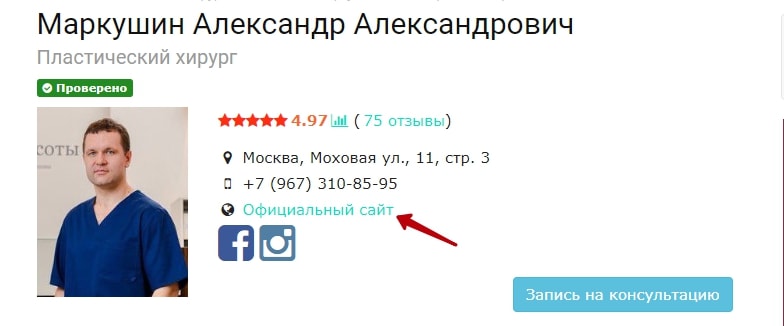

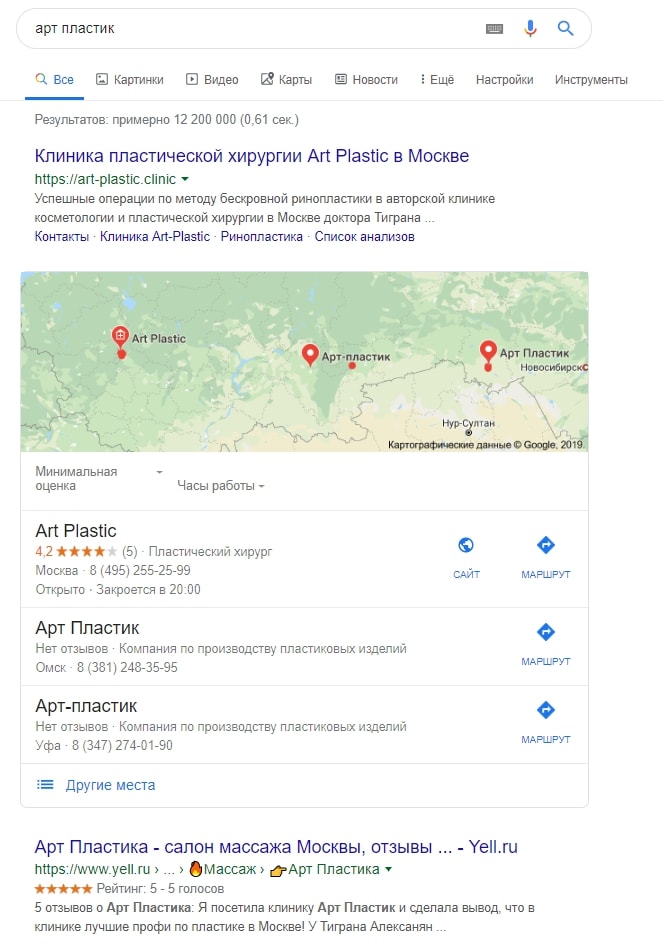

Покажем на примере ссылки на клинику «Art Plastic». Переходим в режим инкогнито, указываем нужный регион, вводим название клиники (или другой поисковый запрос, который интересует) в строку поиска.

Видим, что сайт находится на первом месте по запросу. Это значит, что у него нет проблем с релевантностью, не наложены понижающие санкции. Мы можем поставить ссылку на такой ресурс на своей странице.

Как найти исходящие ссылки, что проверить

В работе с сайтом, помимо технических ошибок, анализа внутренней и внешней оптимизации, рекомендуем также анализировать исходящие ссылки. Аудит нужно проводить, чтобы проверить:

Найти их можно с помощью краулера. Какой лучше выбрать – описали в статье «Автоматизированный парсинг сайтов».

Также для поиска исходящих ссылок можно использовать онлайн-сервисы. Например:

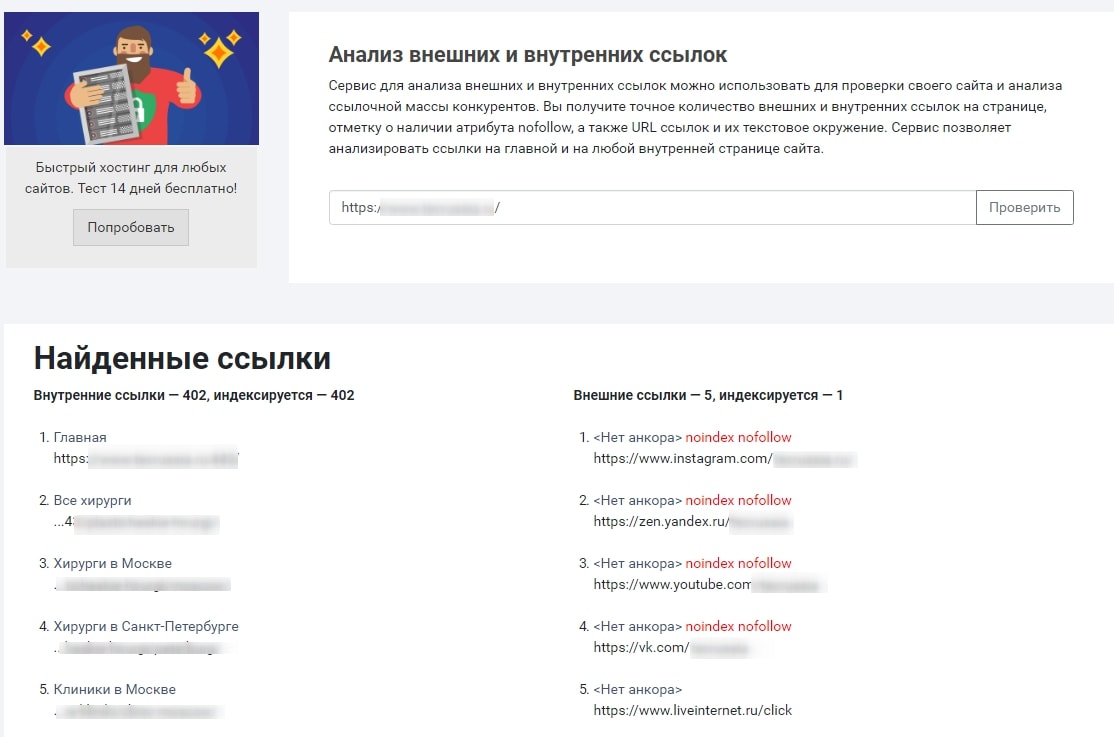

PR-CY.ru

Инструмент бесплатный, можно посмотреть ссылки, которые идут с конкретной страницы. Есть информация об анкоре, индексируется линк или нет.

Результат проверки выглядит так:

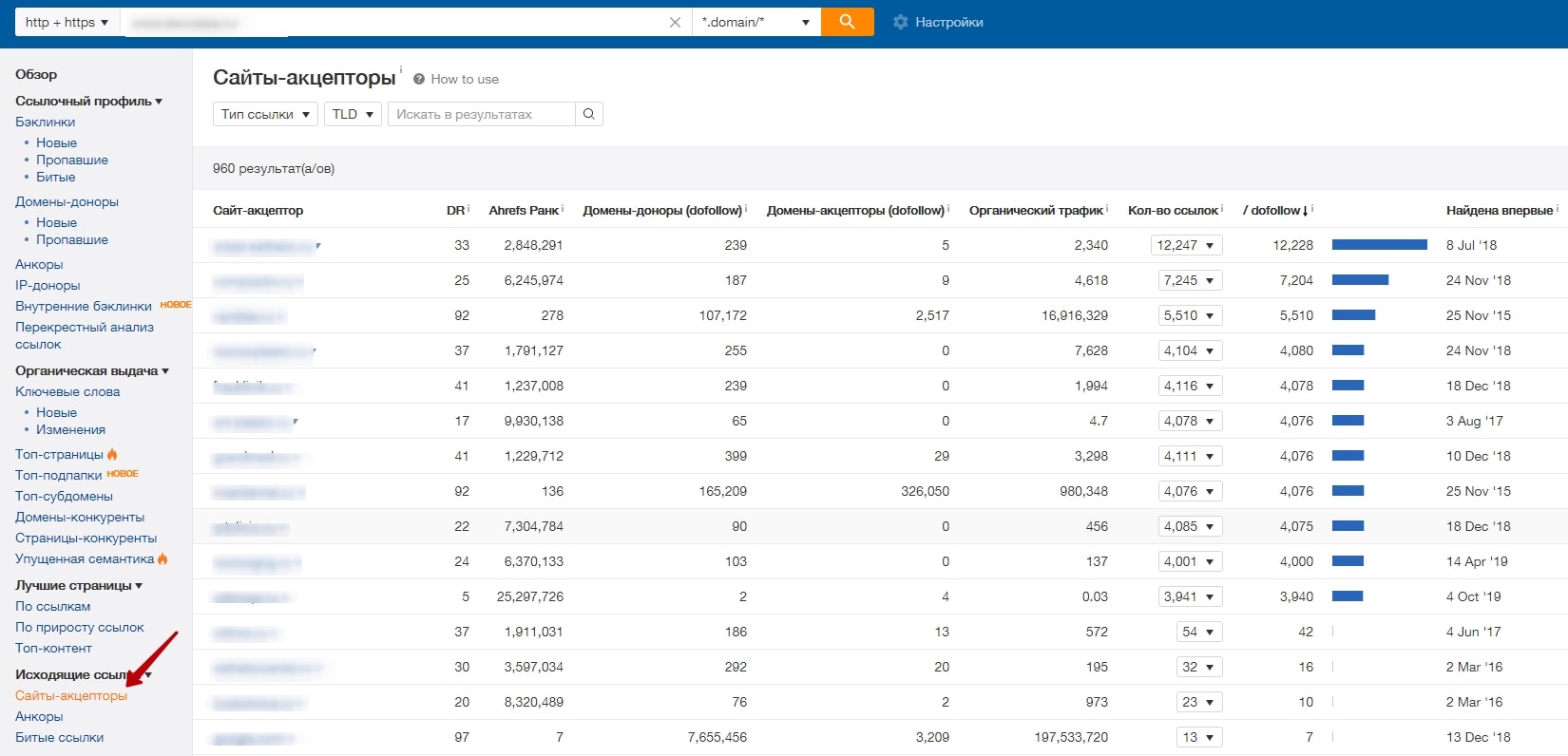

Ahrefs.com

Посмотреть исходящие ссылки можно в отчёте «Сайты-акцепторы». Показывает домен, на который ссылается ваш сайт, его показатели, сколько исходящих ссылок и с какой страницы ведут, анкор. Результат проверки выглядит так:

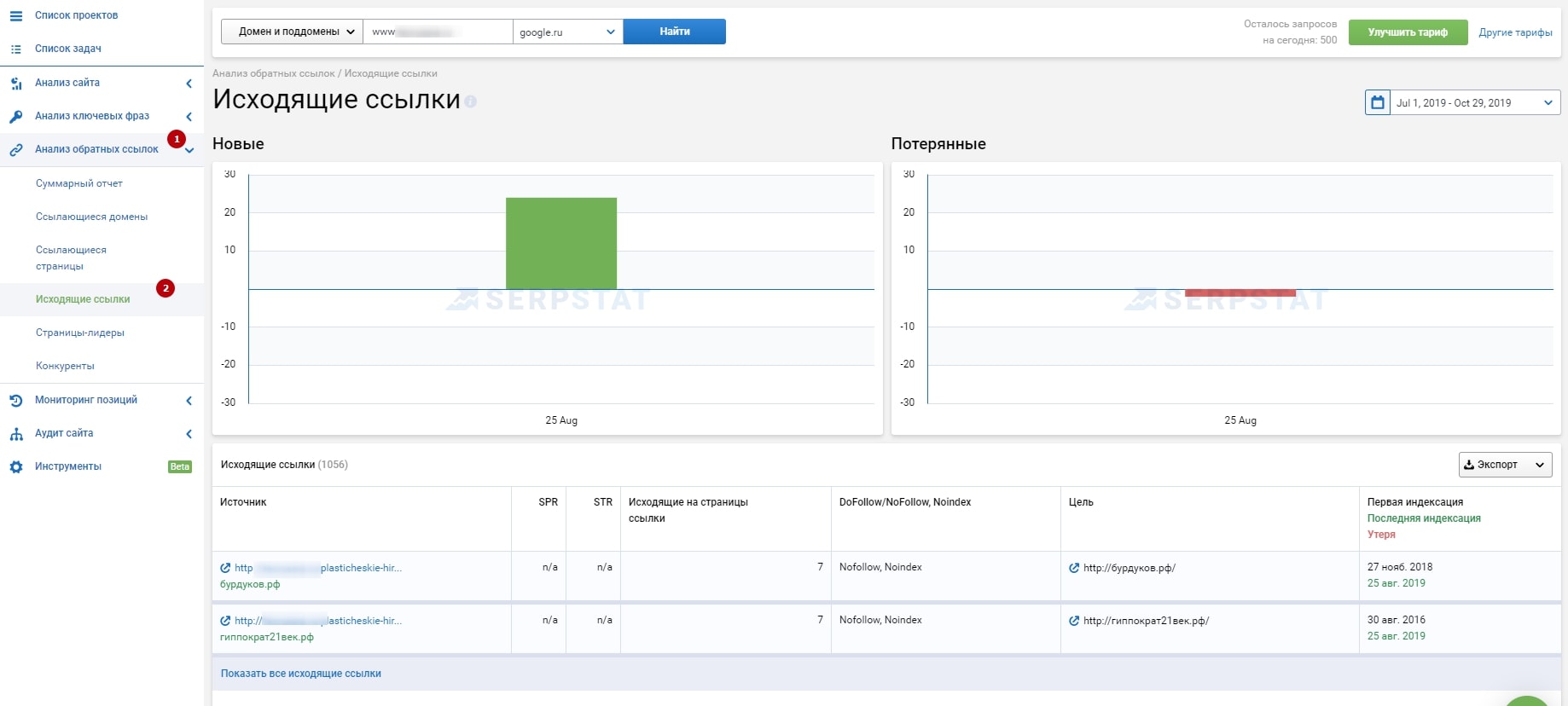

Serpstat.com

Узнать исходящие ссылки можно с помощью инструмента «Исходящие ссылки» в Serpstat.

Показывает ссылки по домену и поддоменам, источник, цель, разрешена ли к индексации, когда была впервые проиндексирована, в последний раз и исчезла с сайта. Есть экспорт.

Рекомендуем оставлять только ссылки на авторитетные трастовые ресурсы. По возможности удалять все исходящие ссылки, которые:

Исследование о влиянии исходящих ссылок на ранжирование от западных экспертов

Кратко об эксперименте:

Чтобы проверить влияние исходящих ссылок на позиции сайта в идеальных условиях, специалисты придумали новый вид косметики с вымышленным названием «Phylandocic» и тестовым переменным словом «Ancludixis». По ним не было ни одного результата в выдаче.

Затем было создано 10 новых сайтов с описанием косметики – по 300 слов на каждом.

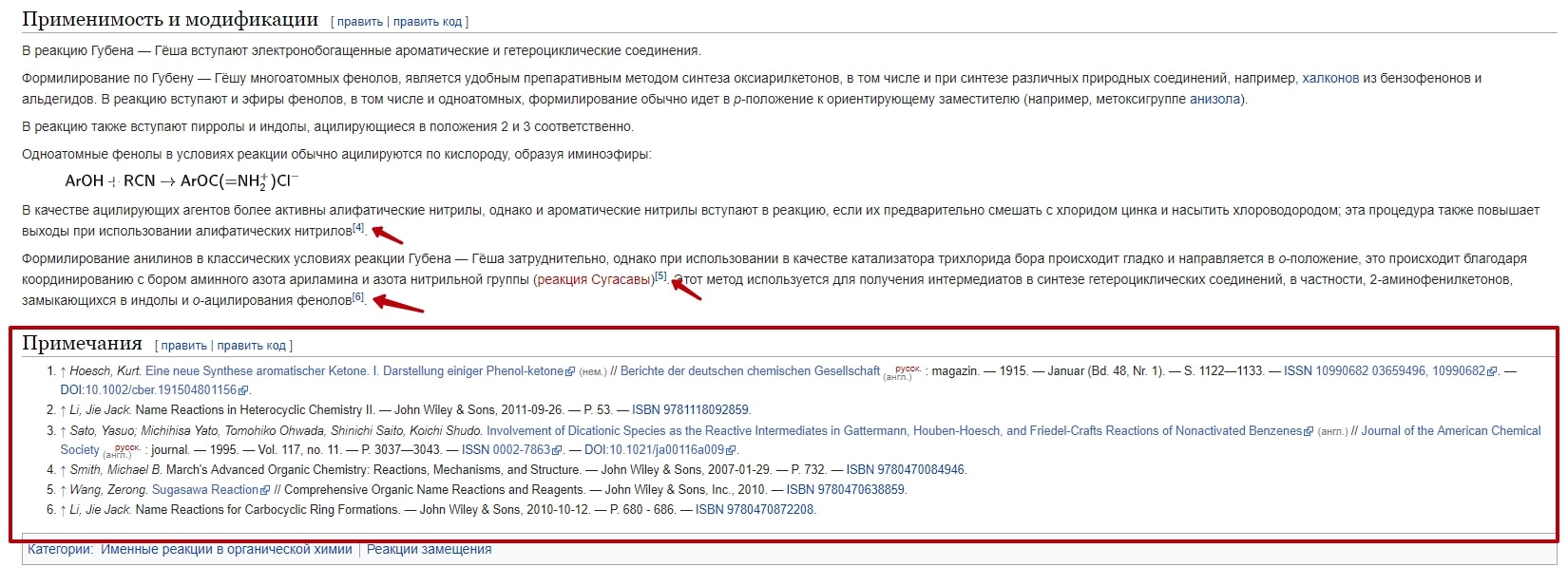

С 5 сайтов поставили ссылки на авторитетные источники:

Чтобы исключить любое внешнее влияние, исследователи:

В результате исследования, которое длилось 5 месяцев, было установлено, что при прочих равных сайты с исходящими ссылками на качественные ресурсы получают позиции лучше, чем без таковых.

Скриншот выдачи через 5 месяцев с начала исследования:

Так какие же ссылки можно ставить, а от каких лучше воздержаться

Положительно влияют:

Отрицательно влияют (как на ваш сайт, как донор, так и на сайт акцептора):

Что касается ссылок на социальные сети – результат может быть как положительным, так и отсутствовать совсем.

Как закрыть исходящие ссылки от индексации

Чтобы скрыть исходящие ссылки от робота Google, в справке поисковой системы рекомендуется использовать несколько вариантов атрибутов rel:

Ссылки, помеченные одним из них, обычно не отслеживаются. Но это не точно 🙂

Чтобы скрыть ссылку от индексации в Яндексе, В Яндекс.Помощи рекомендуют добавить в элемент HTML-кода страницы атрибут rel=»nofollow».

Если хотите закрыть от индексации исходящие ссылки без потери ссылочного веса, рекомендуем выводить их в блоках, реализованных через JavaScript. Так вы с большой вероятностью спрячете ссылку от Яндекса и затрудните её обнаружение для Google.

Заключение

Ставить или не ставить ссылки на другие ресурсы – решать вам. Чтобы лучше в этом разобраться, приведём плюсы и минусы исходящих линков.

Плюсы исходящих ссылок:

Минусы исходящих ссылок:

Постоянно появляются вопросы насчёт оптимизации сайта? Личный SEO-доктор готов ответить!

Исходящие ссылки в 2021 году: работают или нет?

*Статья обновлена 02.02.2021.

Исходящие ссылки: что это такое?

Исходящие ссылки — это ссылки, размещенные на сайте, которые ведут на сторонний ресурс. Как и другие ссылки, они могут быть с анкором и без.

Общий вид исходящей ссылки:

Какие бывают

Есть 2 типа исходящих ссылок:

Обычные (dofollow) ссылки — это естественные исходящие ссылки. Такие ссылки не имеют каких-то атрибутов. Каждая ссылка по умолчанию является dofollow. Она отправляет сигнал в Google PageRank о том, что по целевой ссылке следует переходить ботам.

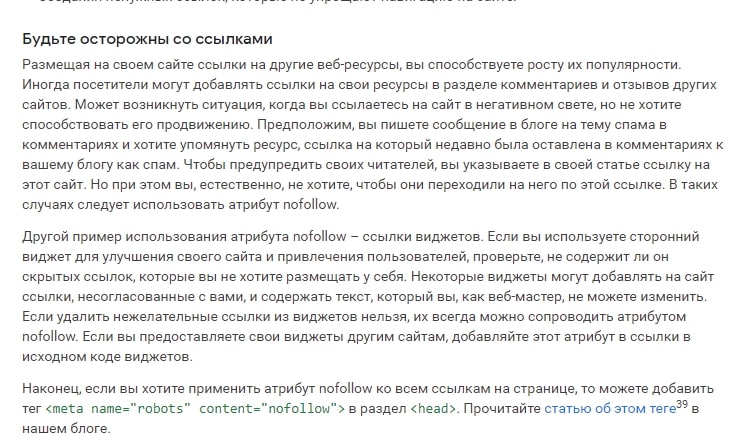

Nofollow ссылки — это исходящие ссылки, котором вы не доверяете. Вы должны изменить код, добавив в него тег rel = ”nofollow”. Он отправляет сигнал в Google PageRank, что не стоит переходить по ссылке.

Атрибуты исходящих ссылок

Вы можете указать у исходящих ссылок разные атрибуты. Используя их, вы просите Google не учитывать такие ссылки при расчете PR. А теперь подробнее про каждый.

В своем посте от 10 сентября 2019 года Google анонсировал 2 новых атрибута ссылок «sponsored» и «ugc» вдобавок к «nofollow».

Атрибут rel = «sponsored» используется для идентификации ссылок, созданных в рекламных, спонсорских или других коммерческих целях. Используя этот атрибут, вы сообщаете поисковику, что ссылка была размещена по предварительному соглашению двух сторон.

Атрибут rel = ”ugc” (User-generated content) или в переводе «пользовательский контент» предназначен для ссылок в комментариях, сообщениях на форуме и т. д.

Раньше Google блокировал все nofollow ссылки и не учитывал их в расчете Pagerank. С 1 марта 2020 года все 3 атрибута будут рассматриваться как «подсказки» для сканирования и индексации. Т.е. Гугл будет видеть эти атрибуты, анализировать ссылки и решать стоит учитывать их или нет.

«Ссылки содержат ценную информацию, которая может помочь нам улучшить поиск. Например, слова в ссылках (анкоры) описывают контент, на который они указывают. Просмотр всех ссылок, с которыми мы сталкиваемся, также может помочь нам лучше понять неестественные шаблоны ссылок. Переходя к модели подсказок, мы больше не теряем эту важную информацию, но при этом позволяем владельцам сайтов указывать, что некоторым ссылкам не следует передавать вес».

Google об исходящих ссылках

«Ссылки на другие веб-сайты — это отличный способ принести пользу вашим посетителям. Часто ссылки помогают пользователям узнать больше, проверить ваши источники и лучше понять, насколько ваш контент соответствует интересующим их вопросам».

Дэнни Салливан (представитель поискового отдела компании Google) делится своими мыслями:

«Я думаю, что ссылки — это часть приписывания авторства. Вы журналист. Вы пишете рассказ, вы цитируете свои источники. Если эти источники находятся в сети и содержат дополнительную информацию для читателя, ссылка на них должна быть указана. Это просто хорошая журналистика. Это должно быть стандартом».

Источник.

Мэтт Каттс (бывший руководитель группы по веб-спаму в Google):

«Я бы не рекомендовал закрывать комментарии, пытаясь «накопить» ваш PageRank. Google меньше доверяет сайтам, когда они ссылаются на спамерские сайты, зато наша система одобряет ссылки на хорошие сайты».

Источник.

В самой же справке Гугла написано следующее:

Самостоятельный хостинг сторонних ресурсов: хороший, плохой, злой

В последние годы всё больше платформ для оптимизации фронтенд-проектов предлагают возможности по самостоятельному хостингу или проксированию сторонних ресурсов. Akamai позволяет задавать специфические параметры для самостоятельно создаваемых URL. У Cloudflare есть технология Edge Workers. Fasterzine может переписывать URL на страницах так, чтобы они указывали бы на сторонние ресурсы, находящиеся на основном домене сайта.

Если известно, что сторонние сервисы, используемые в вашем проекте, изменяются не слишком часто, и то, что процесс их доставки клиентам может быть улучшен, то вы, наверняка, задумываетесь о проксировании подобных сервисов. При таком подходе вы вполне можете «приблизить» эти ресурсы к пользователям и обрести более полный контроль над их кэшированием на клиентской стороне. Это, кроме того, позволяет защитить пользователей от неприятностей, вызванных «падением» стороннего сервиса или деградацией его производительности.

Хороший: повышение производительности

Самостоятельный хостинг чужих ресурсов улучшает производительность вполне очевидным образом. Браузеру не нужно лишний раз обращаться к DNS, ему не надо устанавливать TCP-соединение и выполнять TLS-рукопожатие на стороннем домене. То, как самостоятельный хостинг чужих ресурсов влияет на производительность, можно увидеть, сравнив два следующих рисунка.

Сторонние ресурсы загружаются из внешних источников (взято отсюда)

Сторонние ресурсы хранятся там же, где и остальные материалы сайта (взято отсюда)

Ситуацию улучшает ещё и то, что браузер будет использовать возможности по мультиплексированию и приоритизации данных HTTP/2-соединения, которое уже установлено с основным доменом.

Если не размещать у себя сторонние ресурсы, то, так как они будут загружаться с домена, отличного от основного, их нельзя будет приоритизировать. Это приведёт к тому, что они будут конкурировать друг с другом за полосу пропускания клиента. Это может привести к тому, что время загрузки материалов, критически важных для формирования страницы, окажется гораздо большим, чем время, достижимое при идеальном стечении обстоятельств. Вот выступление об HTTP/2-приоритизации, в котором всё это очень хорошо разъясняется.

Можно предположить, что использование в ссылках на внешние ресурсы атрибутов preconnect поможет в решении проблемы. Однако если таких ссылок на различные домены будет слишком много, это может, на самом деле, перегрузить линию связи в самый ответственный момент.

Если хостить сторонние ресурсы самостоятельно — можно контролировать то, как именно эти ресурсы отдаются клиенту. А именно, речь идёт о следующем:

▍Защита от перебоев в работе сторонних сервисов или от их отключения

Ещё один интересный аспект самостоятельного хостинга сторонних ресурсов заключается в том, что это позволяет смягчить риски, связанные с перебоями в работе сторонних сервисов. Предположим, что используемое вами стороннее решение для проведения A/B-тестирования реализовано в виде блокирующего скрипта, загружаемого в заголовочном разделе страницы. Этот скрипт загружается медленно. Если соответствующий скрипт загрузить не удастся — будет пустой и страница. Если на его загрузку потребуется очень много времени — страница появится с большой задержкой. Или, предположим, в проекте используется библиотека, загружаемая со стороннего CDN-ресурса. Представим, что этот ресурс испытал сбой или был заблокирован в некоей стране. Подобная ситуация приведёт к нарушению логики работы сайта.

Для того чтобы узнать о том, как ваш сайт работает в условиях недоступности некоего внешнего сервиса, можете воспользоваться разделом SPOF на webpagetest.org.

Раздел SPOF на webpagetest.org

▍Как насчёт проблем с кэшированием материалов в браузерах? (подсказка: это миф)

Можно подумать, что использование общедоступных CDN автоматически приведёт к лучшей производительности ресурсов, так как эти службы обладают достаточно качественными сетями и распределены по всему миру. Но всё, на самом деле, немного сложнее.

Предположим, у нас имеется несколько разных сайтов: website1.com, website2.com, website3.com. На всех этих сайтах используется библиотека jQuery. Мы её к ним подключаем, пользуясь CDN, например — googleapis.com. Можно ожидать, что браузер один раз загрузит и кэширует библиотеку, а потом будет использовать её при работе со всеми тремя сайтами. Это могло бы уменьшить нагрузку на сеть. Возможно, это позволит где-то сэкономить и поможет улучшить производительность ресурсов. С практической же точки зрения всё выглядит иначе. Например, в Safari реализована возможность, называемая Intelligent Tracking Prevention: в кэше используются двойные ключи, основанные на источнике документа и на источнике стороннего ресурса. Вот хорошая статья на эту тему.

Старые исследования Yahoo и Facebook, а так же более свежее исследование Пола Кальвано, показывают, что ресурсы не хранятся в браузерных кэшах так долго, как мы могли бы ожидать: «Имеется серьёзный разрыв между временем кэширования собственных и сторонних ресурсов проекта. Речь идёт о CSS и о веб-шрифтах. А именно, срок кэширования 95% собственных шрифтов превышает неделю, в то время как срок кэширования 50% сторонних шрифтов составляет меньше недели! Это даёт веб-разработчикам веские основания для самостоятельного хостинга файлов шрифтов!».

В результате, если вы будете хостить у себя чужие материалы, то не заметите проблем с производительностью, вызванных браузерным кэшированием.

Теперь, когда мы рассмотрели сильные стороны самостоятельного хостинга сторонних ресурсов, давайте поговорим о том, как отличить хорошую реализацию этого подхода от плохой.

Плохой: дьявол кроется в деталях

Перемещение сторонних ресурсов на собственный домен нельзя выполнить автоматически, не позаботившись о правильном кэшировании таких ресурсов.

Но если некая схема версионирования при работе с файлами не применяется, кэшированные скрипты, содержимое которых меняется при неизменном имени файла, могут устаревать. Это способно стать серьёзной проблемой, так как это, например, не позволяет в автоматическом режиме вносить в скрипты исправления безопасности, которые как можно скорее должны получить клиенты. Разработчику придётся приложить усилия к тому, чтобы обновить подобные скрипты в кэше. Кроме того, это может вызвать сбои в работе приложения, вызванные тем, что код, используемый на клиенте из кэша, отличается от свежей версии кода, на которую рассчитана серверная часть проекта.

Правда, если говорить о материалах, которые обновляются часто (менеджеры тегов, решения для A/B-тестирования), то их кэширование средствам CDN — задача хотя и решаемая, но уже гораздо более сложная. Сервисы вроде Commanders Act, решения для управления тегами, при публикации новых версий используют веб-хуки. Это даёт возможность организовать сброс кэша на CDN, или, что ещё лучше, возможность вызова обновления хэша или версии URL.

▍Адаптивная выдача материалов клиентам

Тут можно вспомнить два сервиса. Первый — googlefonts.com. Второй — polyfill.io. Сервис Google Fonts предоставляет, для некоего ресурса, различный CSS-код, зависящий от возможностей браузера (давая ссылки на woff2-ресурсы, используя unicode-range ).

Вот результаты пары запросов к Google Fonts, выполненных из разных браузеров.

Результат запроса к Google Fonts, выполненный из Chrome

Результат запроса к Google Fonts, выполненный из IE10

Polyfill.io выдаёт браузеру только те полифиллы, которые ему нужны. Делается это из соображений производительности.

Например, взглянем на то, что произойдёт, если выполнить следующий запрос из разных браузеров: https://polyfill.io/v3/polyfill.js?features=default

В ответ на такой запрос, выполненный из IE10, придёт 34 Кб данных. А ответ на него, выполненный из Chrome, будет пустым.

Злой: некоторые соображения о приватности

Этот пункт последний по порядку, но не по важности. Речь идёт о том, что самостоятельный хостинг сторонних ресурсов на главном домене проекта или на его поддомен способен поставить под угрозу приватность пользователей и негативно сказаться на основном веб-проекте.

Если ваша CDN-система настроена неправильно, всё может кончиться тем, что вы будете отправлять куки вашего домена стороннему сервису. Если на уровне CDN не будет организована правильная фильтрация, то ваши сессионные куки, которыми в обычных условиях нельзя воспользоваться в JavaScript (с атрибутом httponly ), могут быть отправлены на посторонний хост.

Именно это может произойти с трекерами наподобие Eulerian или Criteo. Сторонние трекеры могли устанавливать уникальный идентификатор в куки. Они, если входили в состав материалов сайтов, могли читать идентификатор по своему усмотрению в ходе работы пользователя с разными веб-ресурсами.

В наши дни большинство браузеров включают в себя защиту от подобного поведения трекеров. В результате теперь трекеры используют технологию CNAME Cloaking, маскируясь под собственные скрипты различных проектов. А именно, трекеры предлагают владельцам сайтов добавить в свои настройки CNAME для некоего домена, адрес которого обычно выглядит как случайный набор символов.

Хотя и не рекомендуется делать так, чтобы куки веб-сайта были доступными для всех поддоменов (например — *.website.com), на многих сайтах это делается. В таком случае подобные куки автоматически отправляются замаскированному стороннему трекеру. Как результат — ни о какой приватности уже можно не говорить.

Кроме того, то же самое происходит и с HTTP-заголовками Client-Hints, которые отправляются лишь главному домену, так как они могут быть использованы для создания цифрового отпечатка пользователя. Обратите внимание на то, чтобы используемая вами CDN-служба правильно фильтровала бы подобные заголовки.

Итоги

Если вы собираетесь в скором времени внедрить самостоятельный хостинг сторонних ресурсов — позвольте дать вам несколько советов:

Распространение статей в интернете. Варианты и их особенности

Причины распространения своих статей в интернете

Закон пиара гласит: «Чем больше народу узнает о тебе, тем больше клиентов воспользуются услугой!» Эта же цель заложена в публикации своих статей на стороннем ресурсе. Каждый сторонний сайт это:

Список сайтов для бесплатной публикации с обратной ссылкой

Форумы со спец разделом (webmasters.ru,maultalk.com)

На что обратить внимание при выборе стороннего сайта

Фильтры. Сайт, предоставляющий возможность бесплатного размещения может быть под АГС. Публикуя в нем ссылки на свой сайт, вы рискуете потерять в ранжировании или еще хуже – попасть под «Минусинск». RDS-бар в помощь.

ТИЦ. Аналогично первому варианту, выбранный сайт может быть под «Минусинском», к тому же, ссылки с сайтов с 0 ТИЦом больше похожи на «заказные».

Трафик. В «мертвом сайте» вашу статью читать никто не будет, следовательно, переходов или расшаривание статьи будет минимальным. Работа проделана впустую.

Варианты размещения статей и их особенности

Поговорим об эффективности каждого способа подробнее.

Размещение статьи на стороннем сайте полным копированием с ссылкой на исходник

Достаточно популярный способ расшаривания информации. Список сайтов, опубликованных чуть выше, позволяет размещать полные статьи. Для ссылки на исходник даже выделено специальное поле. Интересные статьи быстро набирают популярность, обсуждаются и лайкаются. Все бы хорошо, но есть и вторая сторона медали.

Размещение анонсов статей с ссылкой на ресурс

Этот вариант предусматривает публикации на стороннем сайте не всей статьи, а краткого анонса с картинкой. Причем одним заголовком тут не отделаться. Ведь нам нужно заинтересовать аудиторию настолько, чтобы получить переход на наш ресурс. Основная проблема в том, чтобы сделать его максимально интересным. Причем не просто копировать первый абзац, а сделать его уникальным.

Что же касается порталов, то там анонс должен быть побольше в районе 1000 символов. Аудитория таких порталов привыкла сначала оценить «полезность», а потом только совершать переходы.

Говоря о порталах, необходимо учитывать требования к публикациям. Там, где уникальность статьи стоит обязательным пунктом, пишите уникальные анонсы. Где уникальность не важна, публикуйте уже написанные.

К слову, анонс послужит отличным стимулом писать интересные материалы, а не просто засорять статьями интернет.

Программная фишка

Упростить работу с публикациями анонсов в соц. сетях можно с помощью разметки Open Graph. Она позволяет прописывать анонс статьи. В результате при обычном репосте автоматически будет вставляться заголовок, анонс и картинка публикуемой ссылки. Проверить визуальное отображение разметки open graph можно тут.

Я сам долгое время использовал метод полного дублирования. После изучения материалов по этой теме пересмотрел план работ.

Полный список сайтов и комментарии специалистов читайте в источнике.