Некоторые ссылки отсутствуют в результатах поиска причины удаления 1 что значит

Некоторые ссылки отсутствуют в результатах поиска причины удаления 1 что значит

Вчера сайт, который был в выдаче в Яндексе с 2013 года, полностью выпал из индекса.

Внизу поисковой выдачи сообщение: «Некоторые ссылки отсутствуют в результатах поиска в силу требований законодательства РФ. Подробнее»

Домен в списке роскомнадзора с июня 2018 (адалт). Связываю с этим.

На новом домене сделал редирект:

RewriteRule (.*) http://забаненый.ru/$1 [R=301,L]

Домен добавлен в вебмастер.яндекс.

Вопрос такой: как сделать так, чтобы только яндекс проиндексировал сайт по новому домену? По основному домену стабильный трафик с Гугла.

А что там за контент-то?

У коллеги аналогичная ситуация, слежу за темой.

вот похожую тему обсуждают/ru/forum/1003294

Есть вариант, на новом домене раскатываешь зеркало (клон основного сайта).

Новый домен добавляешь только в вебмастерку яндекса,

в роботсе запрещаешь гугл боту индексировать новый домен, и тупо переезжаешь только для яндекса, раз в гугле все ок) а вдруг с гуглом проблемы начнуться, разрешишь гуглу индексировать новый домен.

Оказывается проблема решается просто. Добавил в управлении доменом алиас. Этот алиас в вебмастере яндекса указал основным доменом. Через день главная страница сайта уже была в выдаче. Трафик немного вырос. 4 ноября все страницы сайта уже появились в выдаче по новому домену и трафик восстановился. 🙂

zaxenhausen:

Безобидный адалт.

Оказывается проблема решается просто. Добавил в управлении доменом алиас. Этот алиас в вебмастере яндекса указал основным доменом. Через день главная страница сайта уже была в выдаче. Трафик немного вырос. 4 ноября все страницы сайта уже появились в выдаче по новому домену и трафик восстановился. 🙂

То есть вы просто переехали на новый домен, только на суб домен старого? Только для яндекса? Гуглу что то запретили?

И всего день заняла переклейка? ка кто быстро.

zaxenhausen:

Безобидный адалт.

Оказывается проблема решается просто. Добавил в управлении доменом алиас. Этот алиас в вебмастере яндекса указал основным доменом. Через день главная страница сайта уже была в выдаче. Трафик немного вырос. 4 ноября все страницы сайта уже появились в выдаче по новому домену и трафик восстановился. 🙂

После таких действий небыло скачков трафика??

Страницы низкого качества или как понять, что твой сайт «не очень»

Не так страшен чёрт, как его малюют

– русская пословица

Иногда довольно сложно понять, что от тебя хотят поисковые системы, что именно они понимают под значением «страницы низкого качества»? Порой смотришь на страницу и откровенно не понимаешь, почему же её невзлюбил Яндекс или Google. В этой статье мы рассмотрим страницы, которые ПС удаляют из поиска, считая недостаточно качественными.

Страницы низкого качества в понимании поисковых систем

В блоге Яндекса Елена Першина даёт следующее определение страницы низкого качества: «Под понятием некачественная страница мы понимаем страницы, вероятность показа которых в поиске практически нулевая. По понятным причинам мы не рассказываем способы определения таких страниц, но это чёткий сигнал, что если вы хотите видеть эту страницу в поиске, то со страницей нужно что-то делать».

Внесём немного корректив в слова представителя Яндекса: так как алгоритмы иногда дают сбой, причём в пользу сайтов, страница может занимать ТОП, а потом бесследно пропасть из выдачи.

То есть, страницы низкого качества – это документы, которые не имеют ценности, не несут новую и полезную информацию, не дают релевантный ответ на вопрос пользователя, с точки зрения поисковых систем.

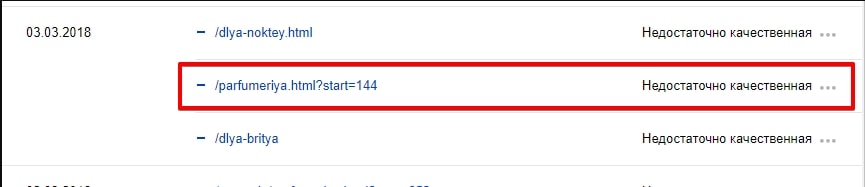

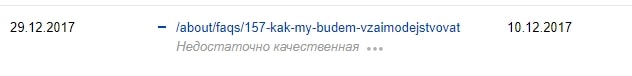

Как обнаружить удалённые низкокачественные страницы

Яндекс.Вебмастер

Проще всего найти исключённые страницы, воспользовавшись инструментом Яндекс.Вебмастер.

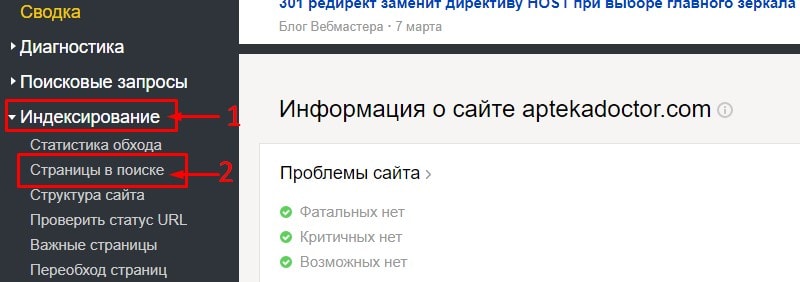

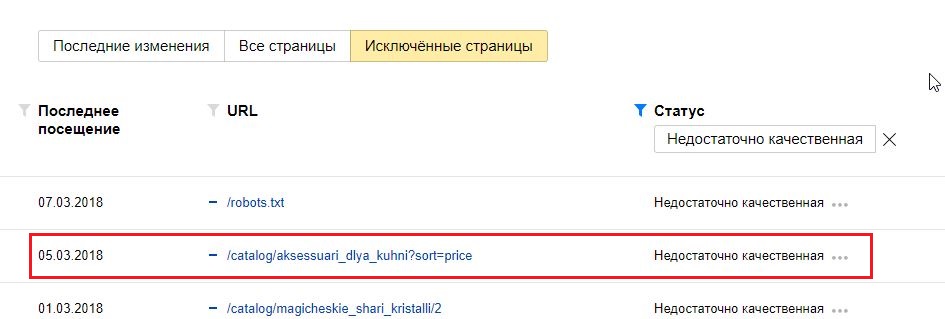

Переходим в раздел «Индексирование» – «Страницы в поиске».

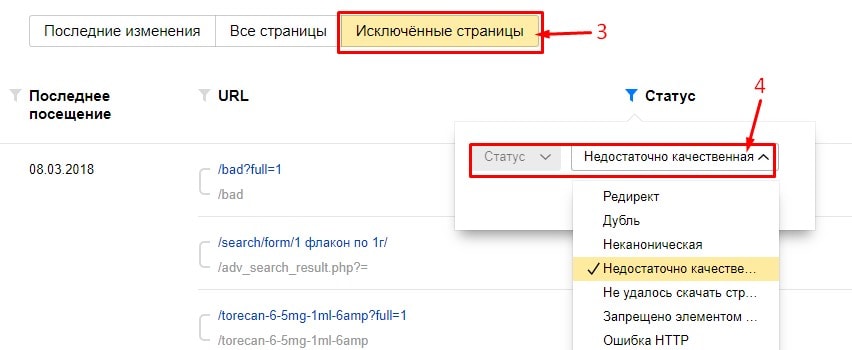

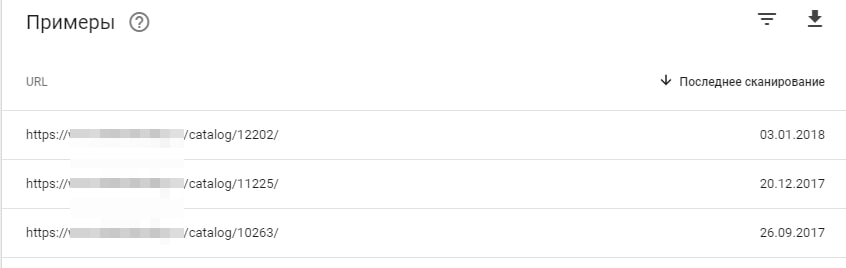

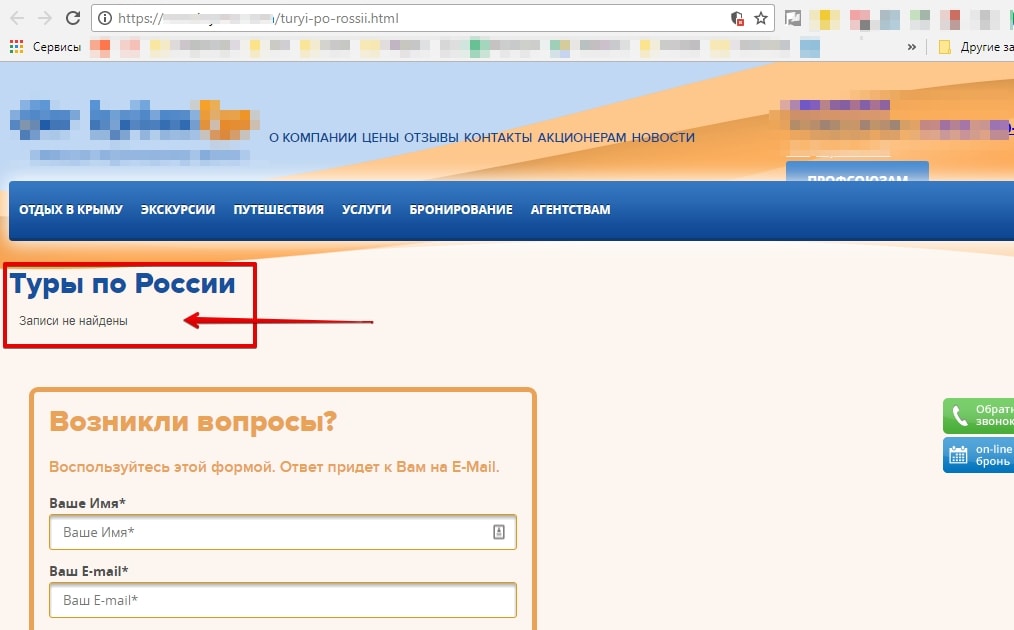

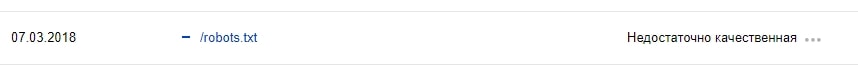

Переходим на вкладку «Исключённые страницы» – выбираем статус «Недостаточно качественная».

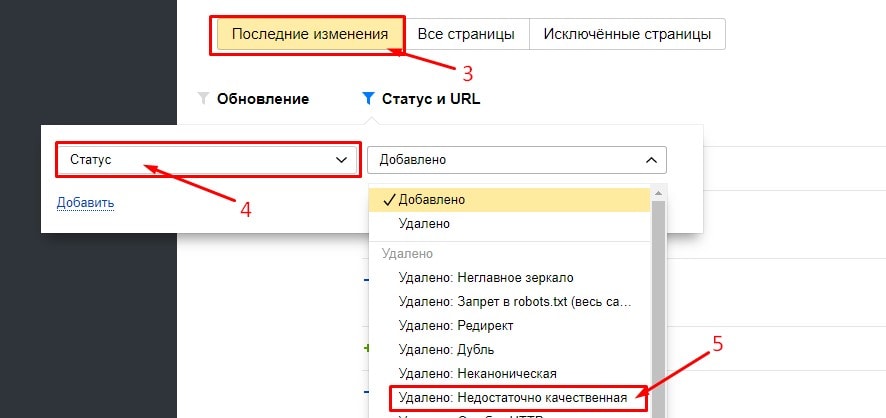

Можно, не переходя с «Последних изменений», выбрать статус «Удалено: Недостаточно качественная».

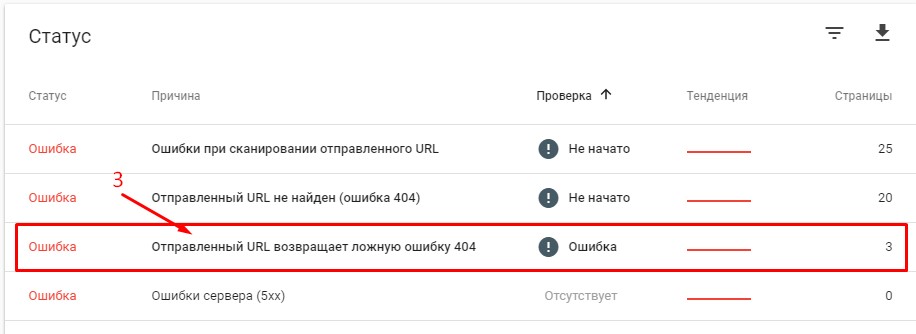

Google Search Console

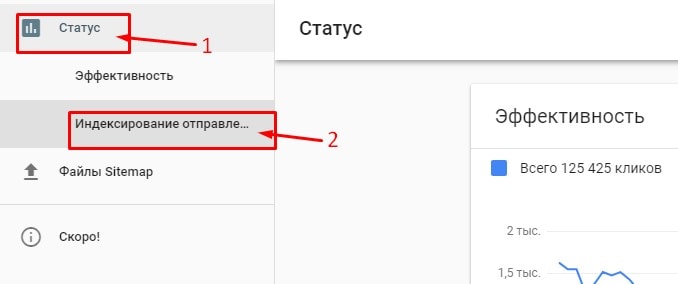

В отличие от Яндекса, Google не предоставляет информацию о том, какие страницы были удалены из поиска из-за качества. Даже в новой бета-версии Google Search Console, к сожалению, эта функция отсутствует.

Единственным сигналом от Google сейчас можно считать «Отправленный URL возвращает ложную ошибку 404». В таких случаях нужно проанализировать страницы, убедиться, что они существуют, а не удалены (и просто ответ сервера некорректен). Подробнее о мягкой 404 можно прочесть в нашем блоге.

Причины удаления страниц

Проанализировав большое количество различных сайтов и выявив закономерность у страниц, удалённых по причине низкого качества, мы пришли к следующим выводам:

1) Алгоритм Яндекса недоскональный: вместо того, чтобы отнести страницу в удалённые, например, по причине дублирования, он исключает её как низкокачественную.

2) Страницы низкого качества чаще встречаются на коммерческих сайтах – интернет-магазинах и агрегаторах, чем на информационных (за счёт автоматической генерации).

Типология удалённых страниц низкого качества

1. «Жертвы» некорректной работы алгоритма

К этой категории мы отнесём страницы, которые должны были быть удалены по другим причинам.

1.1. Дубли страниц

К страницам низкого качества довольно часто попадают дубликаты страниц.

Такие страницы довольно легко определить, если кроме URL ничего не уникализированно.

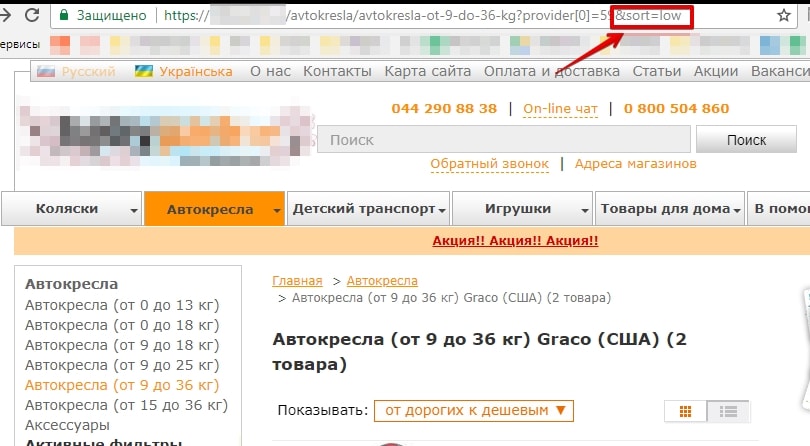

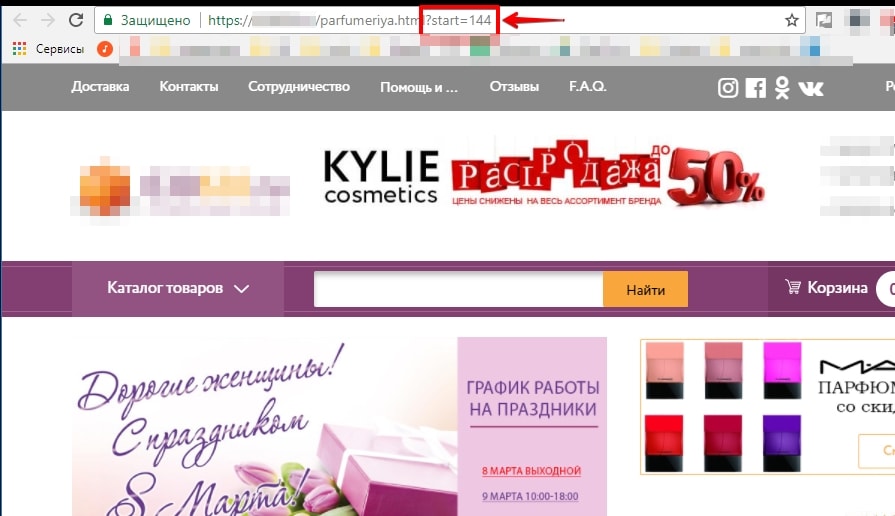

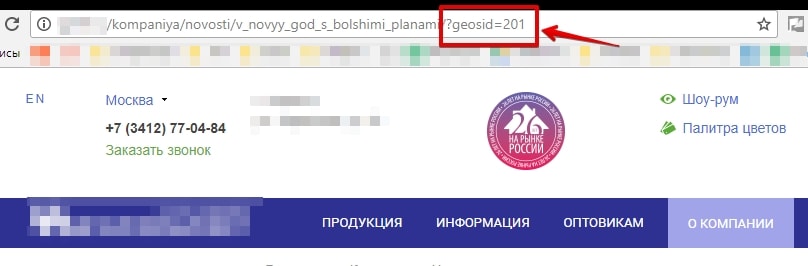

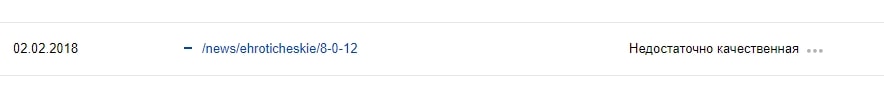

1.2. Страницы сортировки, пагинации и GET-параметры

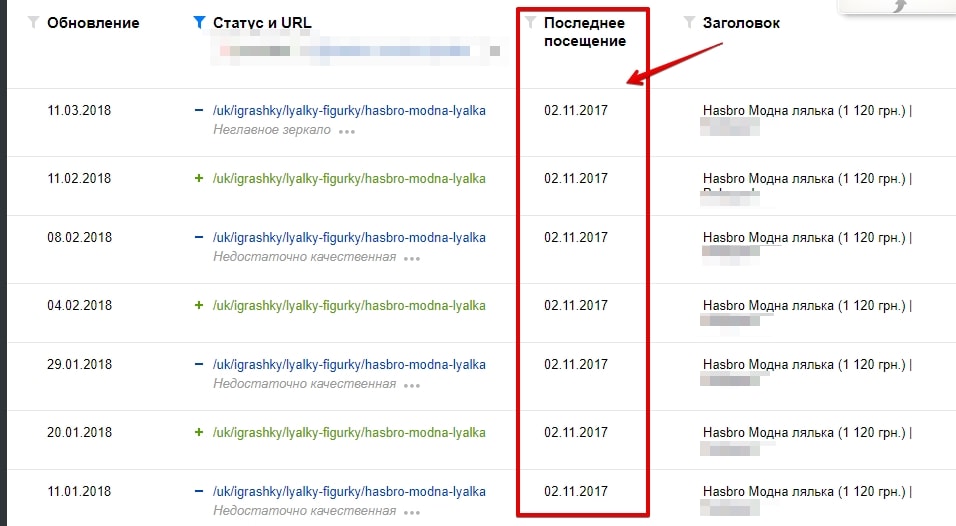

Чаще Яндекс исключает такие страницы, как дубли, но, как показано на примере ниже, они могут быть удалены и по другой причине.

GET-параметры:

В этом примере GET-параметры определяют регион пользователя.

1.3. Неглавное зеркало

Сайт переехал на защищённый протокол. Долгое время робот Яндекса не знал, что делать со старой страницей на HTTP и, то удалял её как некачественную, то добавлял обратно в поиск. По итогу, спустя несколько месяцев, он удалил страницу как неглавное зеркало.

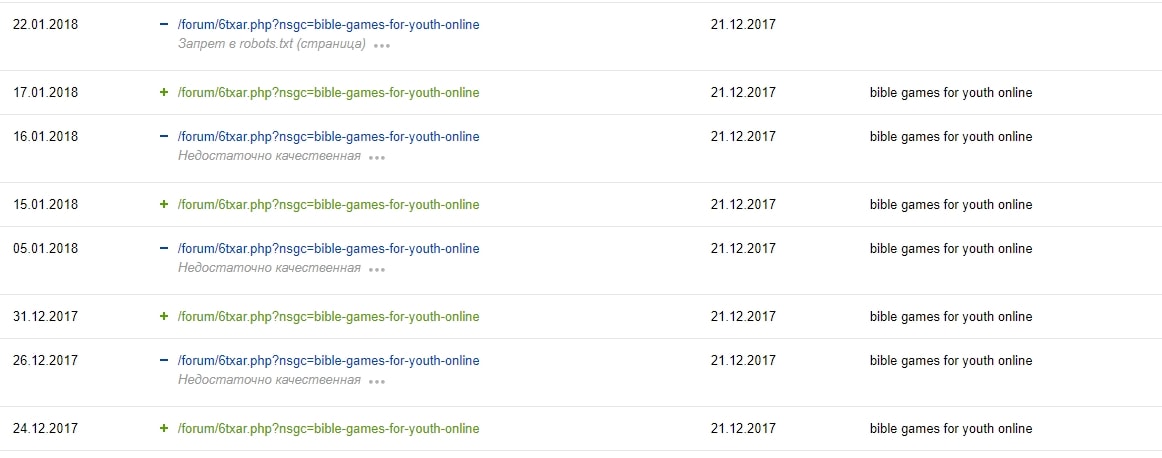

1.4. Страницы, закрытые в файле robots.txt

Директивы в файле robots.txt не являются прямыми указаниями для поисковых роботов, а служат больше рекомендациями. Исходя из практики, бот Яндекса больше придерживается установок, прописанных в файле, чем Google. Но не в этот раз. Как и в прошлом примере, «помучив» несколько раз страницу, он всё-таки «снизошёл» и удалил её из поиска как запрещённую в файле robots.txt.

2. Действительные недостаточно качественные страницы

В эту группу «я плох, бесполезен и никому не нужен» попадают страницы низкого качества, которые действительно являются таковыми.

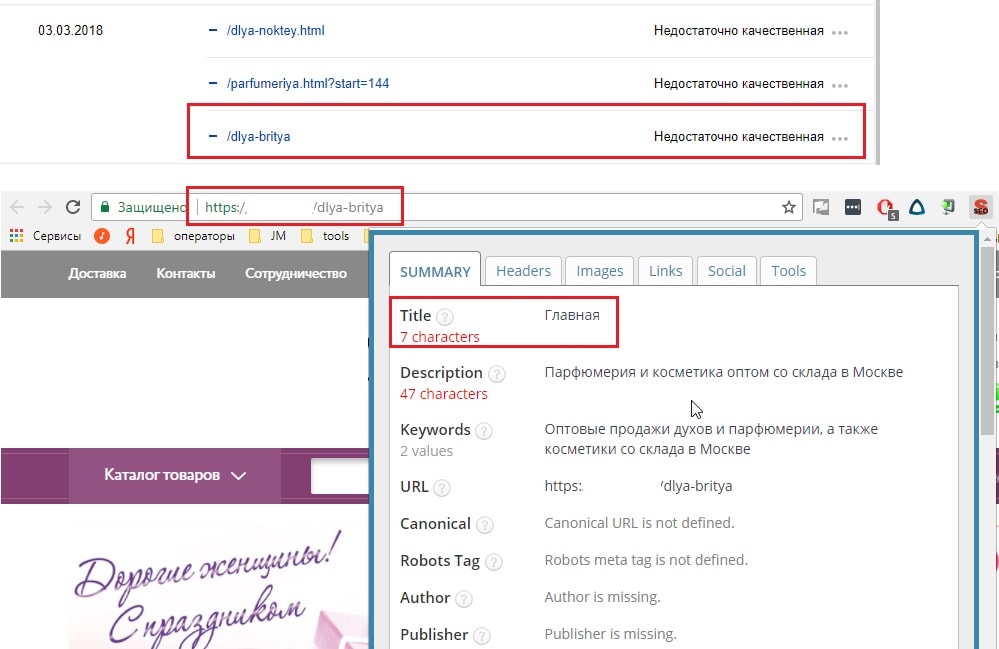

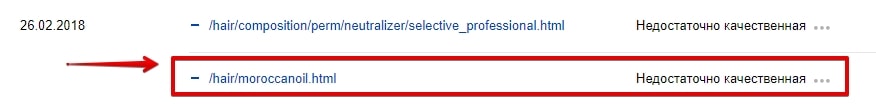

2.1. Шаблонная генерация страниц

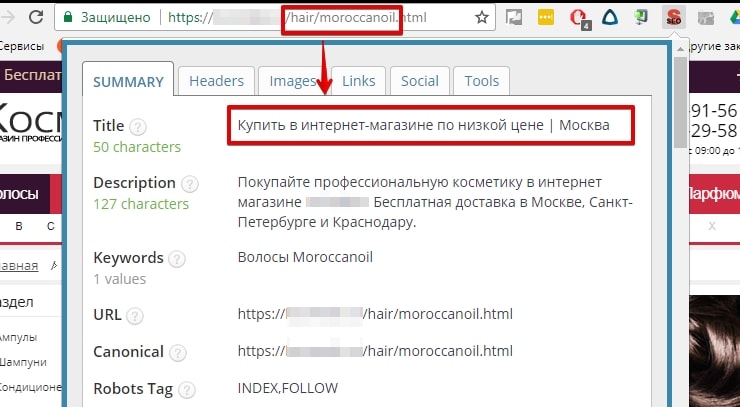

Часто шаблонное заполнение и генерация страниц влечёт за собой ошибки внутренней оптимизации: неуникальные Title, отсутствует Description, с H1 что-то не так и т. д.

Тут важно сказать, что пользователь без проблем поймёт разницу в страницах и для него они могут быть даже полезными, но он о них не узнает, так как роботы стоят на страже порядка не допустят попадания данных страниц в поиск.

Увидев Title на странице, долго не пришлось гадать, что с ней не так.

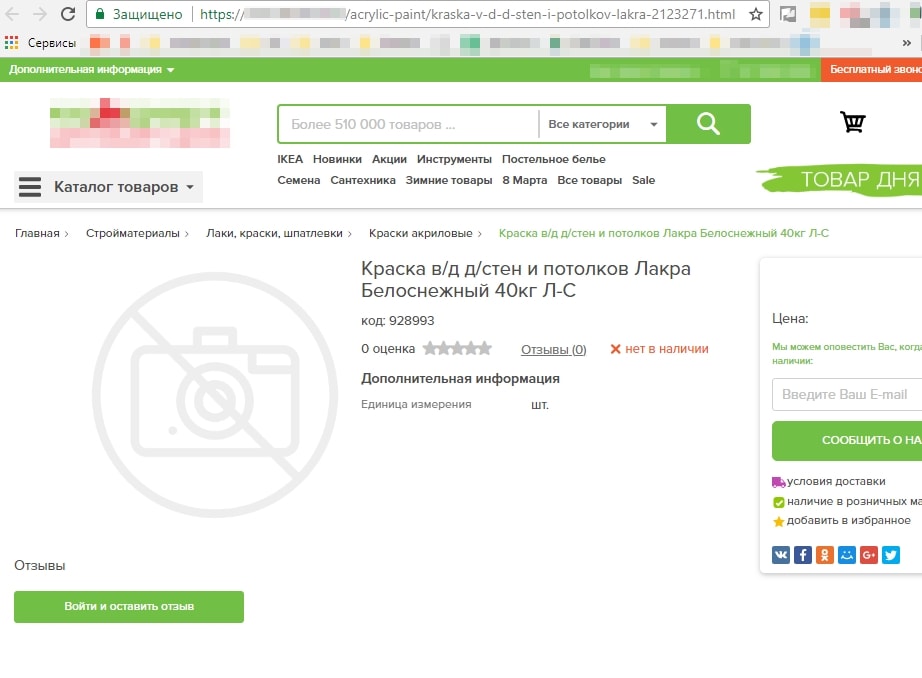

2.2. Плохое заполнение карточек товара

Создать карточку товара просто, а вот наполнить её качественным контентом, описанием товара, изображениями – не каждому под силу.

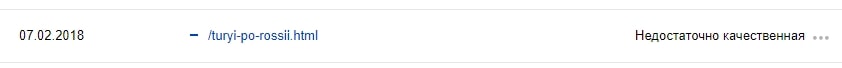

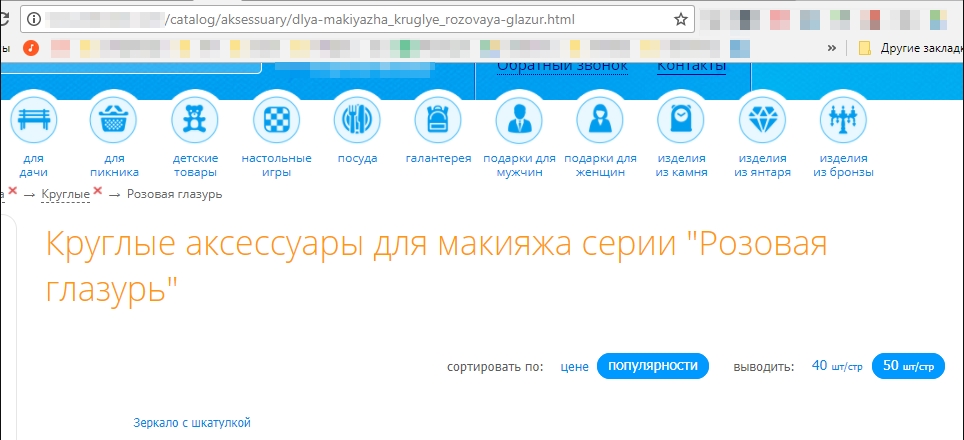

2.3. Листинг без листинга

Создавать страницы категорий/подкатегорий без товара – лишено смысла, так как:

Об этом скажет и сам Яндекс, исключив страницу из поиска как недостаточно качественную.

2.4. Страницы с малым количеством контента

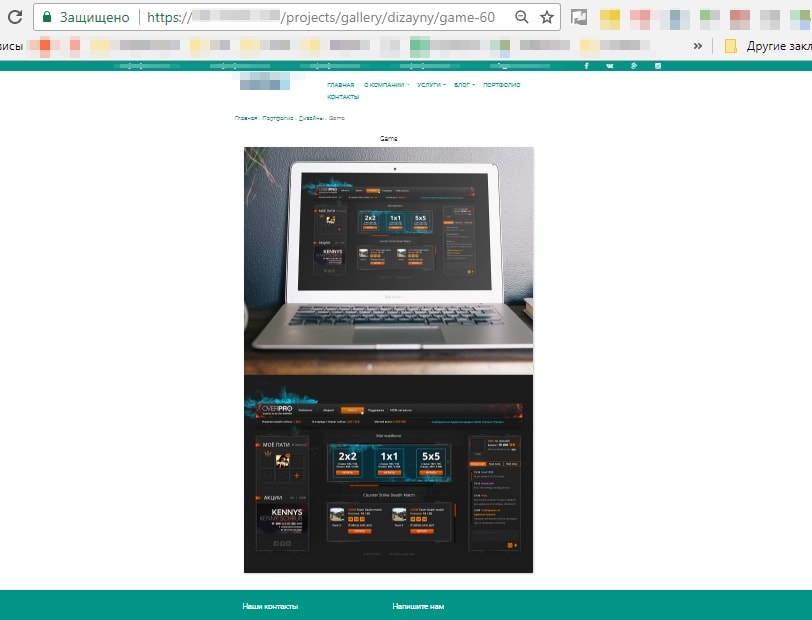

Несмотря на слова поддержки Яндекса, что важно не количество контента, а качество, его отсутствие – не очень хорошая идея.

Например, на этой странице, кроме шаблонной части и двух изображений, ничего нет.

2.5. Страницы, не предназначенные для поиска

Не стоит паниковать, робот о нём знает и помнит. Страница просто не будет отображаться в поисковой выдаче – ну а зачем она там нужна?

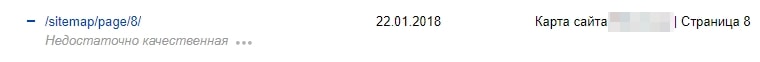

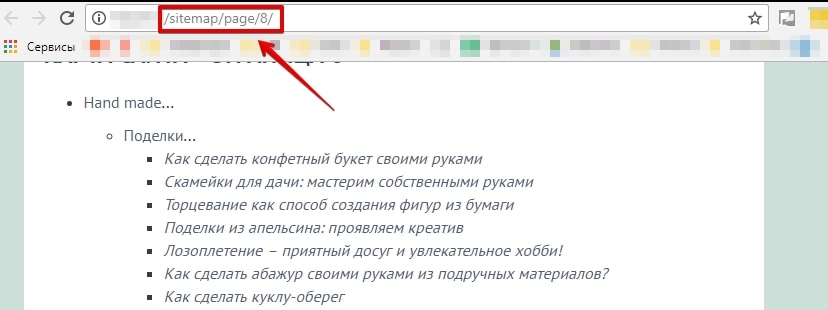

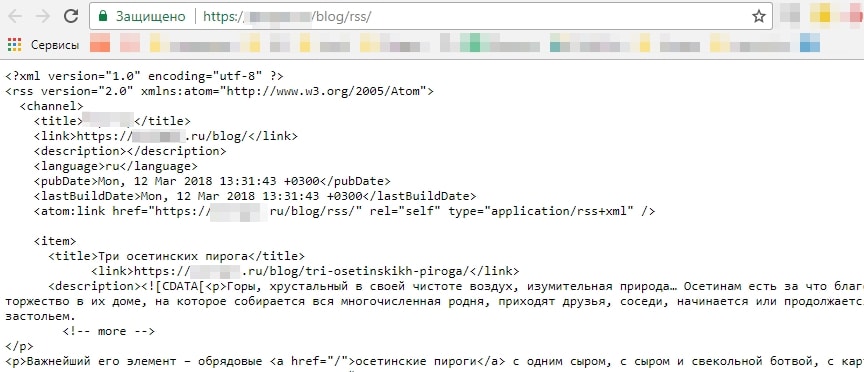

XML- и HTML-карты сайта также исключаются. Особенно если у вас многостраничная карта сайта – какая польза от неё в поиске?

Яндекс считает, что RSS-лентам в поиске тоже нет места.

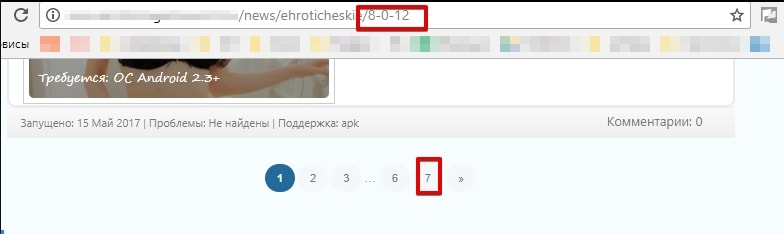

2.6. Страницы с некорректным ответом сервера

В эту группу мы отнесём страницы, которые должны выдавать 404 ответ сервера, а вместо этого отвечают 200 ОК.

Например, это могут быть несуществующие страницы пагинации. Яндекс исключил восьмую страницу пагинации, при имеющихся семи.

Также это могут быть пустые страницы. В таком случае нужно анализировать и принимать решение: настраивать 404 ответ сервера или 301 редирект.

Google может удалить такие страницы, как SOFT 404, но об этом чуть позже.

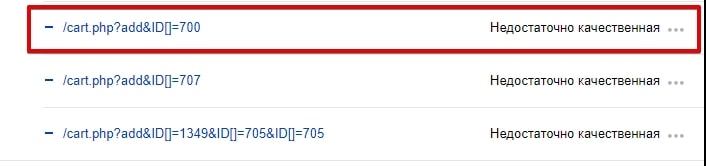

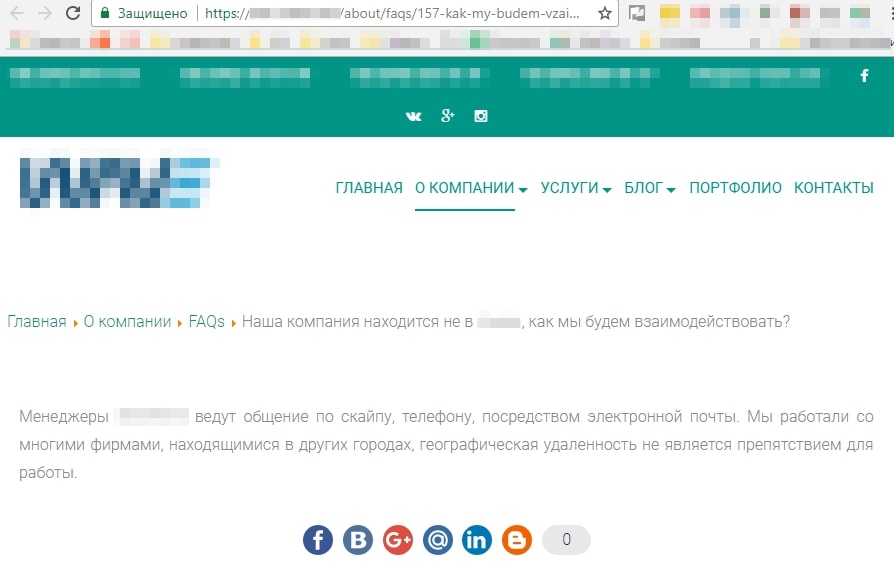

2.7. «Нужно больше страниц»

Этим часто грешат агрегаторы и интернет-магазины, считая, что чем больше страниц, тем больше видимость и трафик. Страницы создают, не беря во внимание их качество и надобность.

Например, низкокачественными являются страницы, созданные под каждый вопрос из FAQ.

Часто бесполезные страницы создаются с помощью применения всех фильтров. Я соглашусь, что нужно думать о посетителях и удобстве пользования сайтом. Если у интернет-магазина большой ассортимент, то структура сайта должна состоять из множества категорий и подкатегорий, а также иметь различные фильтры. Но, во-первых, нужно ли создавать страницу для «Фарфоровых кукол 20 см с голубыми глазами в розовом платье с корзинкой» и, во-вторых, нужны ли такие страницы в поиске?

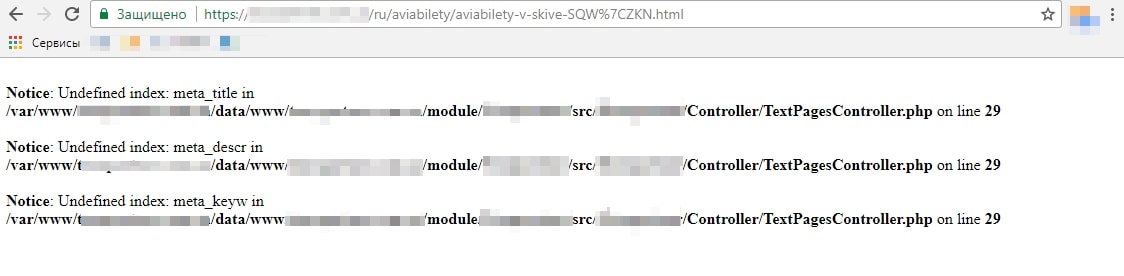

2.8. Технические ошибки

Яндекс не жалует страницы с pop-upом, который перекрывает текст без возможности его закрыть, или случайно созданные страницы под изображения.

Как должно быть и как реализовано на сайте:

Случайно созданная страница:

2.9. SOFT 404

Как мы уже говорили, Google прикрепляет страницам именно такой ярлык. Это могут быть пустые страницы или же страницы с очень малым количеством контента.

Влияние низкокачественных страниц на ранжирование

Сколько бы страниц ни было исключено из поиска по этой причине, на ранжировании остальных страниц сайта это никак не отразится.

Этот алгоритм удаления страниц анализирует каждую страницу отдельно, пытаясь ответить на вопрос: «Если страница будет в поиске, даст ли она релевантный ответ на вопрос пользователя?».

Как говорит Яндекс, страница может быть исключена из поиска даже в том случае, если отсутствуют запросы. Робот может вернуть её, если количество запросов, которым будет релевантна страница, увеличится.

Что же делать со страницами низкого качества

Принимать меры можно только после того, как вы определили причину исключения страницы из поиска. Без выяснения обстоятельств не стоит паниковать, сразу удалять страницы, настраивать 301 редирект.

Алгоритм действий после определения причины удаления страницы:

Дубли страниц: 301 редирект или rel=“canonical”.

Страницы сортировки, пагинации и GET-параметры: настраиваем rel=“canonical”/уникализируем страницы пагинации.

Неглавное зеркало: проверяем 301 редирект, отправляем на переиндексацию.

Страницы, закрытые в файле robots.txt: если страница не нужна в поиске, настраиваем метатег noindex.

Шаблонная генерация страниц: если страница нужна в поиске – уникализируем её, работаем над качеством.

Плохое заполнение карточек товара: добавляем описание товара, изображения и т. д.

Листинг без листинга:

Принимаем действия исходя из результата. Например, если страница приносила трафик и на ней временно отсутствует товар, можно вывести ленту с похожими товарами или со смежных категорий.

Страницы с малым количеством контента: определяем необходимость таких страниц в поиске, если они нужны – наполняем качественным контентом; не нужны – настраиваем метатег noindex.

Страницы, не предназначенные для поиска: тут всё просто – ничего не делаем, просто живём с этим.

Страницы с некорректным ответом сервера и SOFT 404: как бы ни логично это прозвучит, настраиваем корректный ответ сервера.

«Нужно больше страниц»: проверяем, приносили ли такие страницы трафик, определяем, нужны ли они пользователям в поиске, частотны ли запросы – принимаем действия исходя из результата.

Страницы с техническими ошибками: исправляем недочёты/если страницы не нужны – закрываем noindex/настраиваем 404 ответ сервера.

ВАЖНО: выше перечислены общие рекомендации, которые чаще всего предпринимаются в той или иной ситуации. Каждый случай нужно рассматривать в индивидуальном порядке, находить оптимальное решение проблемы.

Заключение

К сожалению, выдача поисковых систем переполнена мусором, некачественным контентом и бессмысленными сгенерированными страницами. Яндекс и Google активно борются с такими страницами, исключая их из поиска. Мы за качественный контент. Поэтому, если у вас возникли трудности, вы наблюдаете, как поисковики удаляют страницы, ссылаясь на недостаточное качество, мы можем провести технический аудит вашего сайта и написать инструкции по решению проблемы.

У Вашего сайта много страниц низкого качества?

Как найти и исправить неработающие внутренние ссылки на сайте

Неработающие внутренние ссылки на сайте ― это плохая новость, как для посетителей вашего сайта, так и для его SEO. Поэтому залог успешного функционирования вашего сайта ― это основательно изучить эту тему и приложить усилие, чтобы понять, каким образом можно устранить «мертвые» ссылки не только сайтов созданных на вордпресс, но и любых других системах.

А так же самописных.

В этом посте мы более детально рассмотрим, почему неработающие внутренние ссылки стоит искать и исправлять, а возможно и удалять. Затем рассмотрим пять различных способов, которые вы можете использовать для поиска и исправления «мертвых» или битых ссылок, без увеличения скорости загрузки вашего сайта.

Неработающие внутренние ссылки негативно влияют на SEO

Неработающие (битые) ссылки вредны для вашего проекта по нескольким причинам:

Для начала это влияет на общее впечатление пользователей вашего сайта. Если кто-то нажимает на конкретную ссылку, то он делает это, потому, что он заинтересован в контенте, на который, как ему пообещали, данная ссылка приведет его. Логично, не правда ли?

Таким образом, когда вы отправляете пользователей по «мертвой» ссылке, то вместо обещанного им контента, вы просто создаете разочарование для посетителей. Поэтому такая ситуация сама по себе является хорошим стимулом для поиска и исправления неработающих внутренних ссылок на вашем сайте.

Неработающие внутренние ссылки не только неудачно влияют на человеческий фактор, но и на роботов. В частности, роботы-пауки используют поисковые системы, такие как Google.

Во-первых, неработающие ссылки бесполезны для Google. Каждая страница 404, с которой сталкивается робот Google, в результате неработающих ссылок ― это живая страница и поисковой робот мог бы ее сканировать.

Кроме того, «мертвые» ссылки также являются пустой тратой вашего «ссылочного капитала». Например, у вас есть неработающая внутренняя ссылка, которая приводит пользователя из одного поста блога в другой. Но вы не получите выгоду от SEO этой внутренней ссылки, пока не сделаете ее активной для пользователя.

Пять способов для поиска и исправления неработающих ссылок

Кроме того что ссылки могут быть не только внутренние, но и внешние, они одинаково вредны для вашего проекта. Теперь пришло время ответить на важный вопрос ― как можно исправить «мертвые» ссылки, а некоторые и удалить.

В следующих разделах мы рассмотрим пять способов исправления неработающих ссылок. Для быстрого перехода к интересующему вас способу, можно воспользоваться меню. Или ознакомиться со всеми способами сразу:

Веб-инструмент для SEO-аудита сайта

Первый способ ― это находить и исправлять неработающие внутренние ссылки при помощи веб-инструмента для SEO-аудита. Ahrefs и SEMrush ― это два наиболее популярных сервиса. Они оба включают в себя очень мощные инструменты для аудита сайтов, с помощью которых вы можете автоматически сканировать ваш сайт на наличие ошибок.

На самом деле Ahrefs дает возможность найти «мертвые» ссылки сразу в нескольких местах.

Вариант 1 ― Поиск неработающих ссылок с помощью инструмента аудита SEMrush

Первый способ найти неработающие ссылки в SEMrush ― это использовать их удивительный инструмент аудита сайта. Просто подставьте домен вашего сайта в нужное поле и дайте ему время осуществить сканирование. Этот процесс может занять приблизительно около 20 минут, в зависимости от размера сайта.

После завершения сканирования, кроме того, что на главном экране будет вся информация, перейдите в меню проблемы. Здесь вы можете увидеть все неработающие ссылки на вашем сайте и внутренние страницы, на которых они появляются. Желательно обновить неработающие внутренние ссылки на актуальные.

Вариант 2 ― Поиск неработающих ссылок с помощью Ahrefs Site Explorer

Следующий способ – это использовать Ahrefs Site Explorer для поиска «битых» ссылок. Но сервис этот платный. Для больших сайтов можно и разок заплатить, хотя бы для того, чтобы знать сколько их, где находятся и куда ведут. Просто вставьте URL своего сайта в специальное поле Ahrefs Site Explorer, далее перейдите к отчету «Обратные ссылки» и нажмите «Неработающие», чтобы увидеть наиболее значимые «мертвые» обратные ссылки вашего сайта.

Вы также можете перейти к отчету «Лучшее по ссылкам» и применить фильтр «404 не найден» в «HTTP-кодах».

Google Search Console

Google Search Console ― это полезный инструмент от Google, который помогает вам «отслеживать, поддерживать и устранять неполадки, связанные с присутствием вашего сайта в результатах поиска Google».

Чтобы начать, для начала вам нужно подтвердить свой сайт с помощью Google Search Console. Затем вы можете начать пользоваться его функциями, включая обнаружение неработающих ссылок.

В рамках своей функциональности Google Search Console включает так же отчет об ошибках сканирования, который позволяет просматривать все страницы, которые вернули ошибку 404 в Google:

При нажатии на любую из этих ссылок откроется всплывающее окно, в котором вы сможете увидеть, какие именно страницы ссылаются на эту страницу ошибки 404. Это позволяет исправить неработающую ссылку именно на этих страницах:

Программа для поиска неработающих ссылок

Помимо веб-инструментов для SEO-аудита вашего сайта, вы также можете найти неработающие ссылки с помощью настольного программного обеспечения.

Самым популярным вариантом является Screaming Frog ― широко известный инструмент SEO, который можно бесплатно использовать для поиска первых 500 «мертвых» ссылок.

Screaming Frog работает на Windows, MacOS и Ubuntu.

После загрузки и установки программы вы узнаете, как использовать ее для поиска неработающих ссылок.

Сначала добавьте URL вашего сайта в верхнем поле и нажмите «Пуск»:

Затем вы можете использовать опцию Responses Codes (Коды ответа), чтобы отфильтровать 404 страницы, а затем использовать функцию Inlinks внизу, чтобы найти ссылки на эти 404 страницы.

Данная программа помогла мне найти неработающие внутренние ссылки на аватарки пользователей оставлявших комментарии. К слову сказать, я для этих целей использовал сервис, но по каким-то причинам взаимодействие сервиса комментариев и аватар явно не сработали.

Ох уж эти «полезные» сервисы.

Mac, Integrity ― это еще один хороший инструмент для SEO, который вы можете использовать для поиска «мертвых» ссылок сайта, если работаете на MacOs

Онлайн-инструмент проверки неработающих ссылок

Если ваш сайт не очень большой, то вы можете воспользоваться бесплатным онлайн- инструментом проверки неработающих ссылок, чтобы найти «мертвые» ссылки.

BrokenLinkCheck.com так же очень прост в использовании. Вы просто заходите на сайт, вставляете свой URL и нажимаете «Поиск неработающих ссылок».

После этого вы можете решить, как предоставлять отчет сервису. К примеру, отправлять отчет об отдельно взятых неработающих ссылках или показать полную картину, т.е. сделать более подробную выгрузку ссылок, но это естественно займет гораздо больше времени:

Далее инструмент перечислит все неработающие внутренние и внешние ссылки, а также предоставит ссылки на страницу, где появляется «мертвая» ссылка.

Затем все, что вам нужно сделать, это зайти и исправить ошибочную ссылку.

Проверка внешних и внутренних ссылок в Яндекс Вебмастер

Почти так же как и в google, Яндекс веб мастер имеет свои возможности по поиску битых ссылок. Для начала, необходимо пройти процедуру регистрации проекта в сервисе. И после соблюдения всех формальностей, вам станут доступны все возможности поисковика.

В меню «ссылки» можно просмотреть все внутренние и внешние ссылки сайта и там же в таблице неработающие, показаны красным цветом.

Как удалить неработающие ссылки в веб-мастере Яндекса

В разделе «Инструменты» доступна функция удаления страниц из индекса. Конечно в ручном режиме проделывать такие операции не совсем удобно, но с другой стороны – никакой оплаты не требуется.

Всегда удаляйте неработающие ссылки

Наличие неработающих ссылок на сайте негативно сказывается как на пользователях, так и на SEO. Поэтому вам стоит чаще заглядывать на ваш сайт и периодически проверять его на наличие «мертвых» ссылок.

Поклонникам движка wordpress, да и не только его, я не советовал бы устанавливать для поиска неработающих внутренних ссылок специальные расширения, по крайней мере, на постоянной основе. А лишь только для поиска. Затем от таких расширений следует избавиться, чтобы не усугублять работу сайта лишними запросами.

Лучше воспользоваться инструментами о которых речь шла выше.

Есть ли другие хорошие решения для проверки неработающих внутренних и внешних ссылок, поделитесь в комментариях.