Необходимость в технологии больших данных возникла потому что

Важность больших данных

Важны ли Большие данные (Big Data)? Может ли каждая организация извлечь из них значительную ценность?

Мы предполагаем, что окончательный ответ большинства менеджеров будет: «Да, есть большой потенциал, но также есть вероятность утонуть в океане данных». (Голдратт, книга «Синдром стога сена»). Тем не менее, раз многие все же считают, что в Big Data нет большой ценности, давайте попробуем защитить важность Больших данных.

Большие данные в исходном смысле – это способность каждой организации относительно дешево хранить огромное количество данных с помощью облачных программных средств для извлечения конкретных данных различных форматов из различных баз данных и организовывать их таким образом, чтобы менеджер мог сфокусироваться на том, что действительно актуально.

Более широкий подход к Большим данным включает в себя огромное количество данных из внешних ресурсов, которые предоставляют к ним свободный или платный доступ через Интернет. Это сервисы Google, Facebook и LinkedIn, и есть также общедоступные базы данных, которые позволяют осуществлять поиск и использование своих данных за определенную оплату.

Кажется очевидным, что некоторые организации, особенно крупные, получают большую ценность от Big Data, например, три оператора Больших данных, упомянутых выше. Эти гигантские организации предлагают сфокусированную рекламу на четко определенную аудиторию. Возможность обратиться к конкретным сегментам рынка может быть использована для получения знаний о предпочтениях своих клиентов.

Бизнес-сектор электронной коммерции, особенно цифровые магазины, использует свои собственные Большие данные, взятые у всех, кто заходит на веб-сайт, и записывает каждый клик, который делает пользователь, чтобы сделать выводы о том, что интересует клиента. Анализ этих накопленных данных открывает путь не только для того, чтобы предлагать больше этому клиенту с хорошими шансами на продажу, но и привлекать этого клиента к новым сделкам. Помимо разгадывания специфического вкуса каждого отдельного клиента, может быть установлено общее понимание отдельных групп клиентов, например, роль цены при выборе товара.

Обычные розничные магазины используют гораздо меньше усилий для сбора данных, которые будут отражать предпочтения клиентов, помимо тривиального анализа фактических продаж. Без прямого доступа к информации о клиенте и, что еще хуже, не зная, какие данные помогут им получить больше продаж, они беспомощны. Розничные магазины много теряют от своей некомпетентности, не собирая необходимые данные.

Таким образом, компании, которые имеют легкий доступ к релевантным данным, находят ответы на важные вопросы и получают большую ценность. Другие организации этого не делают и ценность не получают.

Когда новая технология, такая как способность хранить и анализировать огромные объемы данных, появляется на рынке, она поднимает два, казалось бы, похожих, но фактически разных вопроса:

Многие организации не сразу видят преимущества важной новой технологии, поэтому их ответ на первый вопрос НЕТ.

Однако мы считаем, что необходимо приложить дополнительные усилия для анализа того, что может преодолеть препятствия. В настоящее время организация принимает их как суровую необходимость, но новая технология способна значительно уменьшить ограничение, наложенное препятствием. Затем можно будет увидеть новые возможности.

Второй вопрос Голдратта для оценки ценности новой технологии гласит:

Какое ограничение или барьер устраняет или значительно уменьшает новая технология?

Очевидное ограничение хранилища не является правильным ответом на этот вопрос, поскольку ценность хранения огромного объема данных неясна и может легко привести к растрате усилий. Также уменьшение скорости сбора огромных данных и их удобная организация не всегда повышает ценность.

Но у нас всегда есть желание получить более релевантную информацию о важнейших проблемах, с которыми сталкивается организация. У нас никогда не будет идеальной информации, когда нужно принять решение. Таким образом, принятие решений всегда сопровождается высокой неопределенностью из-за вариаций, а также неизвестных фактов. Хотя эта обычная жизненная ситуация будет преобладать и в будущем, неизвестные факторы могут быть значительно сокращены, если будет собрана правильная релевантная информация и предоставлена лицам, принимающим решения.

Таким образом, мы считаем, что новая ИТ-технология уменьшает следующее ограничение или барьер:

Невозможность получить надежные ответы на вопросы, требующие данных, которые сейчас недоступны.

Например, какие нужные функции отсутствуют в наших текущих продуктах по мнению многих клиентов? Можно задавать клиентам такие вопросы и даже хранить все ответы, но многие из клиентов просто отказываются отвечать. Возможно, они даже не знают, что им не хватает, но, когда они увидят это, они поймут. Можем ли мы ответить на этот вопрос, если мы проанализируем данные из разных источников о том, почему определенные продукты внезапно стали очень популярными?

Неспособность ответить на критически важный вопрос является ключевым ограничением для каждой компании, и поиск действительно релевантных данных должен во многих случаях давать новую информацию, которая вместе с эффективным анализом должна приносить существенную пользу.

Чтобы выявить воспринимаемую связь между данными и информацией, давайте приведем определение, которое Голдратт дал «информации» в своей книге «Синдром стога сена»:

Информация – это ответ на заданный вопрос.

Определение подчеркивает две важных понимания. Одно из них – способность задавать вопросы, потому что в большинстве случаев, когда вы что-то спрашиваете, это вас беспокоит, поэтому ответ на вопрос также является и ответом на потребность.

Второе понимание заключается в том, что для ответа на вопрос требуются определенные данные, и в процессе ответа на вопрос данные становятся информацией.

Для успешного управления организацией необходимо задать вопросы, и каждый из них направлен на выявление необходимого аспекта для одной из двух категорий управленческих потребностей:

Первая категория – это новые инициативы для успеха. Вторая категория – защита ваших тылов. Оба они имеют решающее значение для каждой организации.

Третий вопрос Голдратта:

Каковы нынешние правила использования, шаблоны и поведение, которые обходят ограничение?

Без средств сбора данных из многих источников лица, принимающие решения, должны принимать решения, которые основываются на следующих элементах:

Важнейшим элементом является использование интуиции, основанной на прошлом опыте. Это, безусловно, релевантные данные, но их качество сомнительно. Отсутствие объективности, различные личные предубеждения и очень медленное принятие любых изменений составляют проблематичную сторону интуиции.

Интуиция все еще будет играть большую роль в будущем. Однако способность, обеспечиваемая анализом на основе данных, недоступная без истинно Больших данных, проверять достоверность изначальной интуиции (особенно скрытые исходные посылки), а также быть источником новых идей, которые могут вдохновить новую интуицию, может установить новую связь между анализом и интуицией.

Сторонники TOC утверждают, что помимо интуиции должен быть причинно-следственный анализ, который позволяет менеджерам правильно рассуждать, даже когда фактические данные минимальны. Это иногда верно, но поскольку все причины и следствия основаны на наблюдаемых следствиях, которые не всегда являются истинными фактами, то даже самая надежная логика не может иметь дело со слишком многими неизвестными без надежных данных, на которые можно положиться.

Итак, как нам улучшить нашу способность выявлять новые возможности и возникающие угрозы с помощью новых ИТ-технологий для доступа к огромному объему данных?

Большой ловушкой использования новых ИТ-возможностей является потеря фокуса – инвестирование огромных усилий в поиск данных, их анализ и, в конечном итоге, почти нулевой результат. Это реальная угроза для многих организаций.

Направление решения, которое мы предлагаем, это создание стратегического процесса высокого уровня, выполняемого специальной командой – штабом, который следует шагам:

Вышеупомянутый процесс похож на то, как работают разведывательные бюро разных стран. Приоритеты и средства явно различны. Страны, наиболее важные вопросы которых касаются угроз, гораздо меньше уделяют внимания возможностям, а их средства для сбора данных обычно незаконны и осуществляются по специальному разрешению со стороны правительства.

Настройка процесса подлинной бизнес-аналитики не является тривиальной. Большая ошибка слепого копирования процессов – это игнорирование важных различий. Однако игнорирование сходства и возможности учиться на хорошо зарекомендовавшем себя процессе – еще одна огромная ошибка. Учитывая разницу в этике, приоритетах и средствах, основная потребность и инструменты анализа достаточно схожи, а появление Больших данных делает возможным получить большую ценность.

То, что делает эти усилия достойными внимания, это простой факт, что лежащие в их основе новые идеи не входят в противоречие с какими-либо глубокими парадигмами крупных компаний.

Что такое Big Data и почему их называют «новой нефтью»

Что такое Big Data?

Big Data или большие данные — это структурированные или неструктурированные массивы данных большого объема. Их обрабатывают при помощи специальных автоматизированных инструментов, чтобы использовать для статистики, анализа, прогнозов и принятия решений.

Сам термин «большие данные» предложил редактор журнала Nature Клиффорд Линч в спецвыпуске 2008 года [1]. Он говорил о взрывном росте объемов информации в мире. К большим данным Линч отнес любые массивы неоднородных данных более 150 Гб в сутки, однако единого критерия до сих пор не существует.

До 2011 года анализом больших данных занимались только в рамках научных и статистических исследований. Но к началу 2012-го объемы данных выросли до огромных масштабов, и возникла потребность в их систематизации и практическом применении.

С 2014 на Big Data обратили внимание ведущие мировые вузы, где обучают прикладным инженерным и ИТ-специальностям. Затем к сбору и анализу подключились ИТ-корпорации — такие, как Microsoft, IBM, Oracle, EMC, а затем и Google, Apple, Facebook и Amazon. Сегодня большие данные используют крупные компании во всех отраслях, а также — госорганы. Подробнее об этом — в материале «Кто и зачем собирает большие данные?»

Какие есть характеристики Big Data?

Компания Meta Group предложила основные характеристики больших данных [2]:

Сегодня к этим трем добавляют еще три признака [3]:

Как работает Big Data: как собирают и хранят большие данные?

Большие данные необходимы, чтобы проанализировать все значимые факторы и принять правильное решение. С помощью Big Data строят модели-симуляции, чтобы протестировать то или иное решение, идею, продукт.

Главные источники больших данных:

С 2007 года в распоряжении ФБР и ЦРУ появилась PRISM — один из самых продвинутых сервисов, который собирает персональные данные обо всех пользователях соцсетей, а также сервисов Microsoft, Google, Apple, Yahoo и даже записи телефонных разговоров.

Современные вычислительные системы обеспечивают мгновенный доступ к массивам больших данных. Для их хранения используют специальные дата-центры с самыми мощными серверами.

Помимо традиционных, физических серверов используют облачные хранилища, «озера данных» (data lake — хранилища большого объема неструктурированных данных из одного источника) и Hadoop — фреймворк, состоящий из набора утилит для разработки и выполнения программ распределенных вычислений. Для работы с Big Data применяют передовые методы интеграции и управления, а также подготовки данных для аналитики.

Big Data Analytics — как анализируют большие данные?

Благодаря высокопроизводительным технологиям — таким, как грид-вычисления или аналитика в оперативной памяти, компании могут использовать любые объемы больших данных для анализа. Иногда Big Data сначала структурируют, отбирая только те, что нужны для анализа. Все чаще большие данные применяют для задач в рамках расширенной аналитики, включая искусственный интеллект.

Выделяют четыре основных метода анализа Big Data [4]:

1. Описательная аналитика (descriptive analytics) — самая распространенная. Она отвечает на вопрос «Что произошло?», анализирует данные, поступающие в реальном времени, и исторические данные. Главная цель — выяснить причины и закономерности успехов или неудач в той или иной сфере, чтобы использовать эти данные для наиболее эффективных моделей. Для описательной аналитики используют базовые математические функции. Типичный пример — социологические исследования или данные веб-статистики, которые компания получает через Google Analytics.

«Есть два больших класса моделей для принятия решений по ценообразованию. Первый отталкивается от рыночных цен на тот или иной товар. Данные о ценниках в других магазинах собираются, анализируются и на их основе по определенным правилам устанавливаются собственные цены.

Второй класс моделей связан с выстраиванием кривой спроса, которая отражает объемы продаж в зависимости от цены. Это более аналитическая история. В онлайне такой механизм применяется очень широко, и мы переносим эту технологию из онлайна в офлайн».

2. Прогнозная или предикативная аналитика (predictive analytics) — помогает спрогнозировать наиболее вероятное развитие событий на основе имеющихся данных. Для этого используют готовые шаблоны на основе каких-либо объектов или явлений с аналогичным набором характеристик. С помощью предикативной (или предиктивной, прогнозной) аналитики можно, например, просчитать обвал или изменение цен на фондовом рынке. Или оценить возможности потенциального заемщика по выплате кредита.

3. Предписательная аналитика (prescriptive analytics) — следующий уровень по сравнению с прогнозной. С помощью Big Data и современных технологий можно выявить проблемные точки в бизнесе или любой другой деятельности и рассчитать, при каком сценарии их можно избежать их в будущем.

4. Диагностическая аналитика (diagnostic analytics) — использует данные, чтобы проанализировать причины произошедшего. Это помогает выявлять аномалии и случайные связи между событиями и действиями.

Например, Amazon анализирует данные о продажах и валовой прибыли для различных продуктов, чтобы выяснить, почему они принесли меньше дохода, чем ожидалось.

Данные обрабатывают и анализируют с помощью различных инструментов и технологий [6] [7]:

Как отметил в подкасте РБК Трендов менеджер по развитию IoT «Яндекс.Облака» Александр Сурков, разработчики придерживаются двух критериев сбора информации:

Чтобы обрабатывать большие массивы данных в режиме онлайн используют суперкомпьютеры: их мощность и вычислительные возможности многократно превосходят обычные. Подробнее — в материале «Как устроены суперкомпьютеры и что они умеют».

Big Data и Data Science — в чем разница?

Data Science или наука о данных — это сфера деятельности, которая подразумевает сбор, обработку и анализ данных, — структурированных и неструктурированных, не только больших. В ней используют методы математического и статистического анализа, а также программные решения. Data Science работает, в том числе, и с Big Data, но ее главная цель — найти в данных что-то ценное, чтобы использовать это для конкретных задач.

В каких отраслях уже используют Big Data?

Павел Иванченко, руководитель по IoT «МегаФона»:

«IoT-решение из области так называемого точного земледелия — это когда специальные метеостанции, которые стоят в полях, с помощью сенсоров собирают данные (температура, влажность) и с помощью передающих радио-GSM-модулей отправляют их на IoT-платформу. На ней посредством алгоритмов big data происходит обработка собранной с сенсоров информации и строится высокоточный почасовой прогноз погоды. Клиент видит его в интерфейсе на компьютере, планшете или смартфоне и может оперативно принимать решения».

Big Data в России и мире

По данным компании IBS [8], в 2012 году объем хранящихся в мире цифровых данных вырос на 50%: с 1,8 до 2,7 Збайт (2,7 трлн Гбайт). В 2015-м в мире каждые десять минут генерировалось столько же данных, сколько за весь 2003 год.

По данным компании NetApp, к 2003 году в мире накопилось 5 Эбайтов данных (1 Эбайт = 1 млрд Гбайт). В 2015-м — более 6,5 Збайта, причем тогда большие данные использовали лишь 17% компаний по всему миру [9]. Большую часть данных будут генерировать сами компании, а не их клиенты. При этом обычный пользователь будет коммуницировать с различными устройствами, которые генерируют данные, около 4 800 раз в день.

Сейчас в США с большими данными работает более 55% компаний [11], в Европе и Азии — около 53%. Только за последние пять лет распространение Big Data в бизнесе выросло в три раза.

В Китае действует более 200 законов и правил, касающихся защиты личной информации. С 2019 года все популярные приложения для смартфонов начали проверять и блокировать, если они собирают данные о пользователях вопреки законам. В итоге данные через местные сервисы собирает государство, и многие из них недоступны извне.

С 2018 года в Евросоюзе действует GDPR — Всеобщий регламент по защите данных. Он регулирует все, что касается сбора, хранения и использования данных онлайн-пользователей. Когда закон вступил в силу год назад, он считался самой жесткой в мире системой защиты конфиденциальности людей в Интернете.

В России рынок больших данных только зарождается. К примеру, сотовые операторы делятся с банками информацией о потенциальных заемщиках [12]. Среди корпораций, которые собирают и анализируют данные — «Яндекс», «Сбер», Mail.ru. Появились специальные инструменты, которые помогают бизнесу собирать и анализировать Big Data — такие, как российский сервис Ctrl2GO.

Big Data в бизнесе

Большие данные полезны для бизнеса в трех главных направлениях:

Крупные компании — такие, как Netflix, Procter & Gamble или Coca-Cola — с помощью больших данных прогнозируют потребительский спрос. 70% решений в бизнесе и госуправлении принимается на основе геоданных. Подробнее — в материале о том, как бизнес извлекает прибыль из Big Data.

Каковы проблемы и перспективы Big Data?

Главные проблемы:

Плюсы и перспективы:

В ближайшем будущем большие данные станут главным инструментом для принятия решений — начиная с сетевых бизнесов и заканчивая целыми государствами и международными организациями [15].

Блеск и нищета Big Data

Революция, связанная с анализом больших данных, порождает не только замечательные достижения, но и определенные трудности, в том числе методологического характера. Рассмотрим некоторые из них детальнее.

Говоря об анализе больших данных [1], часто не осознается, что за этой вывеской скрывается несколько совершенно различных по своей природе задач. Здесь мы затронем лишь некоторые. Во-первых, это задачи типа полной, а не частичной расшифровки генома каждого конкретного человека. Понятно, что решение таких задач порождают революции в соответствующих областях.

Например, тотальные расшифровки геномов — в медицине. Может быть, ход этих революций не столь быстрый, как надеялся Стив Джобс, но, тем не менее, революции эти неизбежны. Другой тип задач, где обработка выборок заменяется знаменитой формулой BIG DATA (N=ВСЕ), связан с обработкой всех имеющихся однотипных данных, например, с целью прогнозирования.

Здесь революционность получаемых результатов, хотя в какой-то мере и сохраняется, но несколько блекнет. Например, если вместо выборочных опросов института Гэллапа накануне выборов американского президента, провести тотальный опрос всех избирателей США, то точность прогноза повысится, но, наверняка незначительно. Третий тип задач представляет особый интерес. Это тотальный анализ слабоструктурированных данных. Простейшим вариантом такой слабой структурированности может служить фрагментарная структурированность. Проиллюстрируем фрагментарную структурированность на примере данных, содержащих результаты психологического исследования по некоторой конкретной тематике на основе всех разнотипных анкетирований по ней, содержащихся во всемирной сети. Возникающая здесь проблема извлечения знаний носит фундаментальный характер и потому необходимо остановиться на ней особо.

Как известно, современная наука, первоначально западная, а теперь уже и мировая, возникла на базе осознания новых интеллигибельных сущностей — таблиц типа «объект-признак» [2]. Анализ слабоструктурированных данных, с целью извлечения знаний, непосредственно несводим к анализу такого рода таблиц. Однако, с учетом того, что в обозримом будущем не предвидится создания новой фундаментальной науки, единственным выходом из положения является тот или другой способ сведения таких не табличных данных к табличному виду. Это, конечно, в определенной степени осознается теоретиками BIG DATA и находит выражение в их ключевом тезисе «чем больше данных, тем меньше их точность». Таким образом, BIG DATA рисует громадную панораму, но видеть эту панораму удается лишь как бы через запотевшее стекло. Иначе говоря, имеет место некий информационный аналог соотношения неопределенности Гейзенберга. Оптимистические утверждения специалистов, что революция больших данных заменит установление причинности простым подсчетом корреляций, неверны вдвойне.

Во-первых, наука, собственно говоря, никогда и не ставила перед собой задачу ответить на вопрос «почему», то есть о причинности, довольствуясь, на основе «законов природы» констатацией «если так, то так», то есть, по существу, корреляциями.

Во-вторых, корреляции, оцененные даже по всем данным, сколь колоссальным не было бы N, могут слабо отражать реальную связь, из-за неизбежно слабой точности данных. При этом возникают две проблемы. Первая – минимизировать потери в точности при агрегировании слабоструктурированных данных и вторая – повысить эффективность извлечения знаний из этих неточных данных.

Начнем с первой проблемы. Ввиду самой природы таблиц «объект-признак», в первую очередь необходимо осуществить определенную рубрикацию данных, причем каждая рубрика будет соотнесена с определенным «объектом». Содержание этих рубрик может иметь различный объем и характер, но каждой из них должно быть присуще некоторое качество, позволяющее относить данные именно к этому «объекту». Часто оказывается, что помимо этой первичной рубрикации и первичных объектов, необходимо вводить вторичные внутренние рубрикации и соответственно вторичные объекты. Чтобы не осложнять здесь изложение, опустим часто возникающую необходимость синтеза на основе нескольких вторичных объектов, объектов-конструкций. Проиллюстрируем сказанное на упоминавшемся примере психологического исследования. В первичные рубрики здесь попадут данные отдельных исследований – анкетирований, в качестве вторичных объектов выступят отдельные заполненные анкеты. Перейдем теперь к вопросу о признаках. По нашему мнению здесь многое определяется спецификой области, к которой относятся данные и стоящей перед исследователем задачей. Так, например, в нашем психологическом исследовании обычно необходимо построение неких интегральных признаков первичных объектов, некое усреднение которых по всем этим объектам или неким их кластерам и оказывается искомым «знанием».

Что касается второй проблемы, то хотя большие N и являются фактором облегчающим принятие надежных решений, но неточность данных во многих задачах, растущая темпами на много опережающими N указывает на необходимость разработки алгоритмов принятия решений более мощных, чем это может предложить DATA MINING на сегодняшний день.

По нашему мнению именно этот третий тип задач, связанный со слабоструктурированными большими данными, только и следовало бы по существу называть BIG DATA, так как именно тут возникает необходимость создания качественно нового в обработке данных, а не простого использования возрастающей мощности вычислительных машин.

1. Виктор Майер-Шенбергер, Кеннет Кукьер. Большие данные. Революция, которая изменит то, как мы живем, работаем и мыслим, Издательство «Манн, Иванов и Фербер», 2013.

2. Мишель Фуко. Слова и вещи. Археология гуманитарных наук, М.:«Прогресс», 1977.>

Big Data: что это и где применяется?

Почему все вокруг говорят про большие данные? Какие именно данные считаются большими? Где их искать, зачем они нужны, как на них заработать? Объясняем простыми словами вместе с экспертом SkillFactory — ведущим автором курса по машинному обучению, старшим аналитиком в «КиноПоиске» Александром Кондрашкиным.

Что такое Big Data

Big Data (большие данные) — огромные наборы разнообразных данных. Огромные, потому что их объемы такие, что простой компьютер не справится с их обработкой, а разнообразные — потому что эти данные разного формата, неструктурированные и содержат ошибки. Большие данные быстро накапливаются и используются для разных целей.

Big Data — это не обычная база данных, даже если она очень большая. Вот отличия:

| Не большие данные | Большие данные |

|---|---|

| База записей о тысячах работников корпорации. Информация в такой базе имеет заранее известные характеристики и свойства, ее можно представить в виде таблицы, как в Excel. | Журнал действий сотрудников. Например, все данные, которые создает во время работы колл-центр, где работает 500 человек. |

| Информация об именах, возрасте и семейном положении всех 2,5 миллиардов пользователей Facebook — это всего лишь очень большая база данных. | Переходы по ссылкам, отправленные и полученные сообщения, лайки и репосты, движения мыши или касания экранов смартфонов всех пользователей Facebook. |

| Архив записей городских камер видеонаблюдения. | Данные системы видеофиксации нарушений правил дорожного движения с информацией о дорожной ситуации и номерах автомобилей нарушителей; информация о пассажирах метро, полученная с помощью системы распознавания лиц, и о том, кто из них числится в розыске. |

Объем информации в мире увеличивается ежесекундно, и то, что считали большими данными десятилетие назад, теперь умещается на жесткий диск домашнего компьютера.

60 лет назад жесткий диск на 5 мегабайт был в два раза больше холодильника и весил около тонны. Современный жесткий диск в любом компьютере вмещает до полутора десятков терабайт (1 терабайт равен 1 млн мегабайт) и по размерам меньше обычной книги.

В 2021 году большие данные измеряют в петабайтах. Один петабайт равен миллиону гигабайт. Трехчасовой фильм в формате 4K «весит» 60‒90 гигабайт, а весь YouTube — 5 петабайт или 67 тысяч таких фильмов. 1 млн петабайт — это 1 зеттабайт.

Data Scientist с нуля

Cтаньте дата-сайентистом и приручите большие данные. Вы научитесь выявлять закономерности в данных и создавать модели для решения бизнес-задач.

Скидка 45% по промокоду BLOG.

Как работает технология Big Data?

Источники сбора больших данных делятся на три типа:

Все, что человек делает в сети, — источник социальных больших данных. Каждую секунду пользователи загружают в Instagram 1 тыс. фото и отправляют более 3 млн электронных писем. Ежесекундный личный вклад каждого человека — в среднем 1,7 мегабайта.

Другие примеры социальных источников Big Data — статистики стран и городов, данные о перемещениях людей, регистрации смертей и рождений и медицинские записи.

Большие данные также генерируются машинами, датчиками и «интернетом вещей». Информацию получают от смартфонов, умных колонок, лампочек и систем умного дома, видеокамер на улицах, метеоспутников.

Транзакционные данные возникают при покупках, переводах денег, поставках товаров и операциях с банкоматами.

Как обрабатывают большие данные?

Массивы Big Data настолько большие, что простой Excel с ними не справится. Поэтому для работы с ними используют специальное ПО.

Его называют «горизонтально масштабируемым», потому что оно распределяет задачи между несколькими компьютерами, одновременно обрабатывающими информацию. Чем больше машин задействовано в работе, тем выше производительность процесса.

Такое ПО основано на MapReduce, модели параллельных вычислений. Модель работает так:

MapReduce — не конкретная программа, а скорее алгоритм, с помощью которого можно решить большинство задач обработки больших данных.

Примеры ПО, которое основывается на MapReduce:

Специалисты по большим данным используют оба инструмента: Hadoop для создания инфраструктуры данных и Spark для обработки потоковой информации в реальном времени.

Где применяется аналитика больших данных?

Большие данные нужны в маркетинге, перевозках, автомобилестроении, здравоохранении, науке, сельском хозяйстве и других сферах, в которых можно собрать и обработать нужные массивы информации.

Бизнесу большие данные нужны, чтобы:

Анализ больших данных позволяет не только систематизировать информацию, но и находить неочевидные причинно-следственные связи.

Продажи товаров

Онлайн-маркетплейс Amazon запустил систему рекомендаций товаров, работающую на машинном обучении. Она учитывает не только поведение и предыдущие покупки пользователя, но и время года, ближайшие праздники и остальные факторы. После того как эта система заработала, рекомендации начали генерировать 35% всех продаж сервиса.

В супермаркетах «Лента» с помощью больших данных анализируют информацию о покупках и предлагают персонализированные скидки на товары. К примеру, говорят в компании, система по данным о покупках может понять, что клиент изменил подход к питанию, и начнет предлагать ему подходящие продукты.

Американская сеть Kroger использует большие данные для персонализации скидочных купонов, которые получают покупатели по электронной почте. После того как их сделали индивидуальными, подходящими конкретным покупателям, доля покупок только по ним выросла с 3,7 до 70%.

Найм сотрудников

Крупные компании, в том числе российские, стали прибегать к помощи роботов-рекрутеров, чтобы на начальном этапе поиска сотрудника отсеять тех, кто не заинтересован в вакансии или не подходит под нее. Так, компания Stafory разработала робота Веру, которая сортирует резюме, делает первичный обзвон и выделяет заинтересованных кандидатов. PepsiCo заполнила 10% нужных вакансий только с помощью робота.

Банки

Автомобилестроение

В 2020 году у автоконцерна Toyota возникла проблема: нужно было понять причину большого числа аварий по вине водителей, перепутавших педали газа и тормоза. Компания собрала данные со своих автомобилей, подключенных к интернету, и на их основе определила, как именно люди нажимают на педали.

Оказалось, что сила и скорость давления различаются в зависимости от того, хочет человек затормозить или ускориться. Теперь компания разрабатывает систему, которая будет определять манеру давления на педали во время движения и сбросит скорость автомобиля, если водитель давит на педаль газа, но делает это так, будто хочет затормозить.

Медицина

Американские ученые научились с помощью больших данных определять, как распространяется депрессия. Исследователь Мунмун Де Чаудхури и ее коллеги загрузили в прогностическую модель сообщения из Twitter, Facebook и Reddit с геометками. Сообщения отбирали по словам, которые могут указывать на депрессивное и подавленное состояние. Расчеты совпали с официальными данными.

Госструктуры

Большие данные просто необходимы госструктурам. С их помощью ведется не только статистика, но и слежка за гражданами. Подобные системы есть во многих странах: известен сервис PRISM, которыми пользуются ФБР и ЦРУ для сбора персональных данных из соцсетей и продуктов Microsoft, Google и Apple. В России информацию о пользователях и телефонных звонках собирает система СОРМ.

Маркетинг

Социальные большие данные помогают группировать пользователей по интересам и персонализировать для них рекламу. Людей ранжируют по возрасту, полу, интересам и месту проживания. Те, кто живут в одном регионе, бывают в одних и тех же местах, смотрят видео и читают статьи на похожие темы, скорее всего, заинтересуются одними и теми же товарами.

При этом регулярно происходят скандалы, связанные с использованием больших данных в маркетинге. Так, в 2018 году стриминговую платформу Netflix обвинили в расизме из-за того, что она показывает пользователям разные постеры фильмов и сериалов в зависимости от их пола и национальности.

Медиа

С помощью анализа больших данных в медиа измеряют аудиторию. В этом случае Big Data может даже повлиять на политику редакции. Так, издание Huffington Post использует систему, которая в режиме реального времени показывает статистику посещений, комментариев и других действий пользователей, а также готовит аналитические отчеты.

Система в Huffington Post оценивает, насколько эффективно заголовки привлекают внимание читателя, разрабатывает методы доставки контента определенным категориям пользователей. Например, выяснилось, что родители чаще читают статьи со смартфона и поздно вечером в будни, после того как уложили детей спать, а по выходным они обычно заняты, — в итоге контент для родителей публикуется на сайте в удобное для них время.

Логистика

Использование больших данных помогает оптимизировать перевозки, сделать доставку быстрее и дешевле. В компании DHL работа с большими данными коснулась так называемой проблемы последней мили, когда необходимость проехать через дворы и найти парковку перед тем, как отдать заказ, съедает в общей сложности 28% от стоимости доставки. В компании стали анализировать «последние мили» с помощью информации с GPS и данных о дорожной обстановке. В результате удалось сократить затраты на топливо и время доставки груза.

Внутри компании большие данные помогают отслеживать качество работы сотрудников, соблюдение контрольных сроков, правильность их действий. Для анализа используют машинные данные, например со сканеров посылок в отделениях, и социальные — отзывы посетителей отделения в приложении, на сайтах и в соцсетях.

Обработка фото

До 2016 года не было технологии нейросетей на мобильных устройствах, это даже считали невозможным. Прорыв в этой области (в том числе благодаря российскому стартапу Prisma) позволяет нам сегодня пользоваться огромным количеством фильтров, стилей и разных эффектов на фотографиях и видео.

Аренда недвижимости

Сервис Airbnb с помощью Big Data изменил поведение пользователей. Однажды выяснилось, что посетители сайта по аренде недвижимости из Азии слишком быстро его покидают и не возвращаются. Оказалось, что они переходят с главной страницы на «Места поблизости» и уходят смотреть фотографии без дальнейшего бронирования.

Компания детально проанализировала поведение пользователей и заменила ссылки в разделе «Места поблизости» на самые популярные направления для путешествий в азиатских странах. В итоге конверсия в бронирования из этой части планеты выросла на 10%.

Кто работает с большими данными?

Дата-сайентисты специализируются на анализе Big Data. Они ищут закономерности, строят модели и на их основе прогнозируют будущие события.

Например, исследователь больших данных может использовать статистику по снятиям денег в банкоматах, чтобы разработать математическую модель для предсказания спроса на наличные. Эта система подскажет инкассаторам, сколько денег и когда привезти в конкретный банкомат.

Чтобы освоить эту профессию, необходимо понимание основ математического анализа и знание языков программирования, например Python или R, а также умение работать с SQL-базами данных.

Data Scientist с нуля

Вы освоите Python и SQL, познакомитесь с машинным обучением и определитесь со специализацией: Machine Learning, Computer Vision или Natural Language Processing. Скидка 5% по промокоду BLOG.

Аналитик данных использует тот же набор инструментов, что и дата-сайентист, но для других целей. Его задачи — делать описательный анализ, интерпретировать и представлять данные в удобной для восприятия форме. Он обрабатывает данные и выдает результат, составляя аналитические отчеты, статистику и прогнозы.

С Big Data также работают и другие специалисты, для которых это не основная сфера работы:

Освойте все инструменты, необходимые junior-аналитику и получите востребованную профессию за 6 месяцев.

Скидка 45% по промокоду BLOG.

Дата-инженер занимается технической стороной вопроса и первый работает с информацией: организует ее сбор, хранение и первоначальную обработку.

Дата-инженеры помогают исследователям, создавая ПО и алгоритмы для автоматизации задач. Без таких инструментов большие данные были бы бесполезны, так как их объемы невозможно обработать. Для этой профессии важно знание Python и SQL, уметь работать с фреймворками, например со Spark.

Курс подходит для тех, кто имеет базовые знания языка Python. За два месяца вы освоите все важные этапы Data Engineering.

Скидка 45% по промокоду BLOG.

Александр Кондрашкин о других профессиях, в которых может понадобиться Big Data: «Где-то может и product-менеджер сам сходить в Hadoop-кластер и посчитать что-то несложное, если обладает такими навыками. Наверняка есть множество backend-разработчиков и DevOps-инженеров, которые настраивают хранение и сбор данных от пользователей».

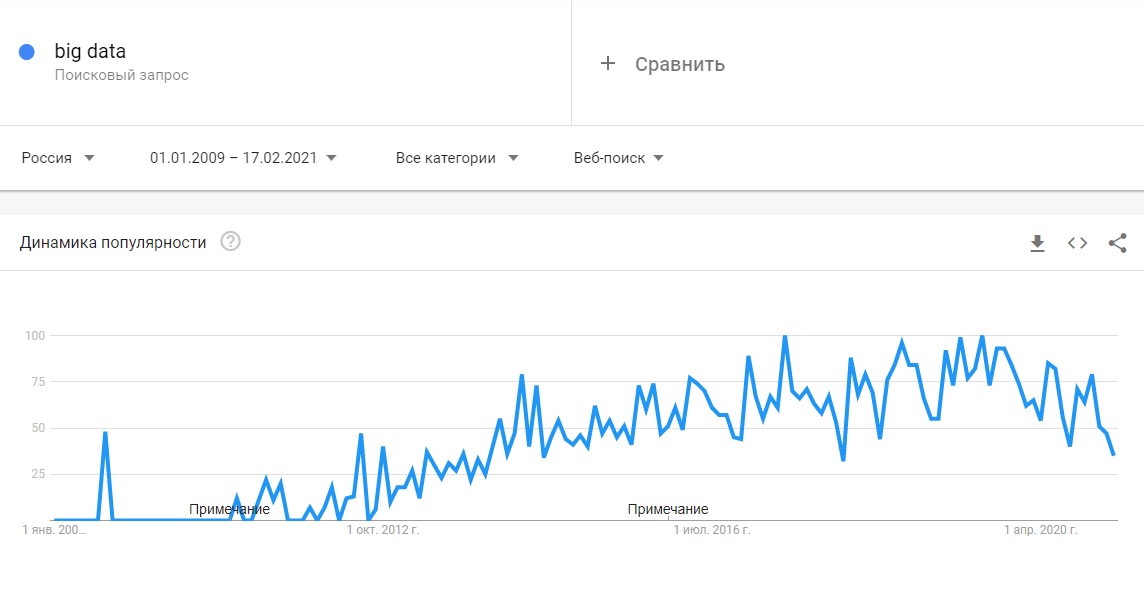

Востребованность больших данных и специалистов по ним

Востребованность больших данных растет: по исследованиям 2020 года, даже при пессимистичном сценарии объем рынка Big Data в России к 2024 году вырастет с 45 млрд до 65 млрд рублей, а при хорошем развитии событий — до 230 млрд.

Вместе с популярностью больших данных растет запрос и на тех, кто может эффективно с ними работать. В середине 2020 года Академия больших данных MADE от Mail.ru Group и HeadHunter провели исследование и выяснили, что специалисты по анализу данных уже являются одними из самых востребованных на рынке труда в России. За четыре года число вакансий в этой области увеличилось почти в 10 раз.

Более трети вакансий для специалистов по анализу данных (38%) приходится на IT-компании, финансовый сектор (29%) и сферу услуг для бизнеса (9%). В сфере машинного обучения IT-компании публикуют 55% вакансий на рынке, 10% приходит из финансового сектора и 9% — из сферы услуг.

Как начать работать с большими данными?

Проще будет начать, если у вас уже есть понимание алгоритмов и хорошее знание математики, но это не обязательно. Например, Оксана Дереза была филологом и для нее главной трудностью в Data Science оказалось вспомнить математику и разобраться в алгоритмах, но она много занималась и теперь анализирует данные в исследовательском институте.

Еще несколько историй людей, которые успешно освоили data-профессию

Если у вас нет математических знаний, на курсе SkillFactory «Data Science с нуля» вы получите достаточную подготовку, чтобы работать с большими данными. За год вы научитесь получать данные из веб-источников или по API, визуализировать данные с помощью Pandas и Matplotlib, применять методы математического анализа, линейной алгебры, статистики и теории вероятности для обработки данных и многое другое.

Чтобы стать аналитиком данных, вам пригодится знание Python и SQL — эти навыки очень популярны в вакансиях компаний по поиску соответствующей позиции. На курсе «Аналитик данных» вы получите базу знаний основных инструментов аналитики (от Google-таблиц до Python и Power BI) и закрепите их на тренажерах.

Важно определиться со сферой, в которой вы хотите работать. Студентка SkillFactory Екатерина Карпова, рассказывает, что после обучения ей была важна не должность, а сфера (финтех), поэтому она сначала устроилась консультантом в банк «Тинькофф», а теперь работает там аналитиком.

Data Science с нуля

Освойте все необходимые инструменты для уровня junior и получите самую востребованную IT-профессию 2021 года.